physics and astronomy.

physics and astronomy.

[X]-Salta NOTA. (Vai subito alla MAPPA della PAGINA)...

NOTA inportante (27.09.2004):

Per navigare nel sito, sono richiesti i seguenti

requisiti: Quick

Time

come lettore multimediale predefinito. [Se

nel riquadro a sinistra vedete una Q

su uno sfondo bianco e poi un Pinguino,

allora avete QuicK

Time come lettore multimediale predefinito; altrimenti sarete

re-indirizzati al sito www.apple.com per il DOWNLOAD

del plug-in -sperando che la

FACILITY introdotta, funzioni. Avvolte -in casi rarissimi-

si può verificare un errore di caricamento del plug-in.

L'utente viene avvisato per mezzo di un

[ALLERT: ERRORE

PLUG-IN: I dati

richiesti dal plugin non sono stati scaricati con successo.

-- Se si dispone di Windows Xp,

invece dell'ALLERT, si osserverà

-nella finestra del plugin-, una pellicola spezzata -35 mm- su

sfondo bianco --]. Questo

"errore",

è causato da un alto traffico dei SERVER nei quali

l'intero sito è DISTRIBUITO. Il tempo massimo di

ripristino del problema -sul quale stiamo lavorando

affinchè non si verifichi-, non supera quasi mai le

3 ore [Il problema pare risolto

!! Stiamo svolgendo ulteriori TEST !!]-.

Mi auguro che il filmato sia di vostro gradimento !!].

Qualche volta alcuni filmati saranno visibili

in RealPlayer.

Questo può causare una automatica imposizione gerarchica del lettore

multimediale RealPlayer

sul lettore di default. Si passa cioè da

Quick

Time a RealPlayer

super-ordinato. Se

ciò dovesse succedere, ripristinare Quick

Time come lettore multimediale predefinito. Come

si fa ? Semplice.

E' QuickTime

che, in background, si accorge che alcuni file associati ad esso, sono stati

associati ad un altro lettore multimediale. In virtù di ciò,

comparirà un ALLERT

[Configurazione

di tipo MIME]

con il seguente messaggio: "Alcuni

MIME precedentemente

associati al plugin QuickTime

sono attualmente associati ad altre applicazioni.

Si desidera ripristinare queste associazioni

dei tipi MIME con

QuickTime

?".

Alla domanda, si DEVE rispondere: "SI".

-- In poche parole, fare attenzione di abilitare la lettura di file MPEG

ed AVI su Quick

Time player e disattivarli su RealOne

player ---. Se l'operazione di ripristino del lettore multimediale di default

avviene a pagina già aperta, tutti i plug-in Quick

Time non possono essere visti -sarebbe meglio dire:

"letti".

Si consiglia di chiudere il browser e ricaricare

la pagina--; >>ATTENZIONE<<...

alla fine del

download di QuickTime

player, viene chiesto un CODICE. Nella versione

gratuita questo codice non è necessario. Cliccare su avanti e proseguire

l'installazione. Per quanto riguarda il download

di Real

Player --chiamato realONE

Player-- fare attenzione di non scaricare la versione Premium

in prova per 14 gg. Il LINK

per il download di realONE

Player si trova in alto a destra del sito

real.com.

Se vi dovesse essere difficoltà, cliccare [QUI].

Essendo real.com un sito commerciale, alla fine

del download, viene riproposto all'utente un prospetto per scaricare...

la versione Premium. Scegliere "INSTALLAZIONE

di BASE"-gratuita-.

Una volta installato realONE,

disattivare l'abilitazione alla lettura dei file MPEG ed

AVI... [riprendere

da: "Sono

richiesti..."];

JAVA JIT attivato o

eventualmente JAVA

Sun .-- Se uno dei due compilatori

JAVA fosse stato disattivato, una sua riattivazione

richiede un riavvio del sistema. --. Macromedia ActiveX

FLASH player+SHOCKWAVE

player. Alcuni LINK,

fanno riferimento a file con estensione .PDF o .PS.

Dunque, per poterli leggere, è necessario scaricare Adobe-Acrobat

Reader -per i file .PDF-

e GSview -per

i file .PS- Sono molto pochi i LINK

a file di tipo Microsoft PowerPoint.

Per poterli leggere è necessario disporre del programma OFFICE

Microsoft. Se si dispone di un Firewall,

configurarlo secondo i valori di default, cercando di non

innalzare troppo la protezione. [Cosa

significa; Firewall: Un

firewall (letteralmente: parete

antincendio o muro di fuoco) è

un sistema per prevenire un accesso non autorizzato a/da una rete privata.

I firewall possono essere implementati sia in hardware che software. Generalmente

si mette un firewall tra la macchina o la rete da proteggere e la rete esterna.

Esistono diversi tecniche di firewall. Filtro

dei pacchetti: Controlla ogni singolo pacchetto

e applica le regole di filtraggio definite dall'utente, che in genere sono

del tipo: "blocca

tutti i pacchetti provenienti da qualsiasi indirizzo, destinati a una particolare

macchina o range di indirizzi sulla porta xxxx".

A livello di applicazione:

Vengono controllati solo determinate applicazioni come i server FTP,

Telnet, etc. A livello di

connessione: Vengono testate solo le connessioni

e una volta stabilite, non vengono più effettuati altri controlli.

Server proxy:

Simile al filtro dei pacchetti, ma nasconde gli indirizzi delle macchine

da proteggere, e non è trasparente come il primo. In altre parole

necessita di configurazioni particolari delle applicazioni come il browser

o client ftp, che per comunicare con l'esterno devono indirizzare

le richieste al proxy.].

Se è stato installato un AntiSpam

-normalmente uno dei più diffusi è Norton-, è

conveniente disattivarlo. Infatti il filtro

antispam -nella navigazione WEB-, non solo

rallenta il DOWNLOAD delle pagine, ma può determinare

una non corretta visualizzazione delle .GIF -molto spesso

quelle animate- e una non visualizzazione di alcune immagini .JPG

di grandi dimensioni. L'operazione non è copmlessa; bastano

alcuni click per disattivare o riattivare l'AntiSpam.

La scheda grafica deve essere almeno 64 Mb --

infatti, se si dispone di una connessione veloce ma una scheda grafica inferiore

a 64 Mb -ciò implica anche una minore velocità

della CPU ad essa dedicata ed altre cose tecniche

nelle quali non mi addentro- si ha, come principale sintomo, un rallentamento

dello scrolling [alto-basso]

di pagina rischiando, nella peggiore delle ipotesi, il blocco

del sistema. La cache memory del sistema deve

esserere almeno 512 Mb. Può andar bene anche una

cache memory di 256 Mb, ma in questo caso,

si consiglia -vivamente- di chiudere alcuni programmi che

girano in back-ground e di cercare di aprire -se è

possibile- il minor numero di finestre del browser -o di

applicazioni [applicazione

= finalità specifica a cui è dedicato

un programma o un sistema di elaborazione]-,

durante la navigazione; infatti, una apertura forsennata di applicazioni

può verificare -in condizioni particolari, sulle quali non mi

dilungo ulteriormente- un over-flow di memoria anche

nel caso in cui la R.A.M. -in uso- sia molto robusta. Potete

usare questa pagina, come TEST

per valutare se il vostro sistema ha le caratteristiche richieste per poter

continuare nella navigazione.--. Si consiglia di aggiornare DirectX

all'ultima realise. Si consiglia, inoltre, di aggiornare -se possibile-

il DRIVER della scheda grafica in uso. La cache

dell'Internet temporary file

deve essere configurata almeno a qualche Giga, se la velocità di connessione

è bassa. Questo serve per non continuare a ricaricare immagini, filmati,

FLASH ecc. rivisitando una stessa pagina.. La velocità

di connessione minima, deve essere: ISDN

64+64 = 128 Kb/s o, --ottimale--,

ADSL a

640 Kb/s o superiore. La memoria RAM

del sistema deve essere almeno 128 Mb (DDRAM).

Sarebbe meglio disporre di un programma

di RAM defrag -per farlo girare in background,

con campionamento risorse a bassa frequenza e possibilità di defrag manuale

over xxx Mb RAM-. Una FACILITY

molto interessante per la didattica --mi riferisco

alla fase di apprendimento-- è la seguente; la possibilità

di disporre di un PLUG-IN per la

sintesi VOCALE. In altre parole, la lettura di un TESTO,

con voce sintetica, usufruendo della semplice procedura copia+incolla.

Il PLUG-IN al quale mi riferisco è MyVoice.

Per scaricare questo "ausilio

didattico", cliccare [QUI].

Una volta installato il PLUG-IN, per poter effettuare la

lettura dei testi -in lingua italiana- selezionati nel sito, cliccare

[QUI].

Fatto il copia+incolla sulla finestra di "dialogo",

cliccare su "Leggi".

Il programma di sintesi VOCALE

è molto intuitivo. Per quanto riguarda i collegamenti alle pagine

del sito, questi sono strutturati in LINK+(argomento)+New+

(letteralmente: parete

antincendio o muro di fuoco) è

un sistema per prevenire un accesso non autorizzato a/da una rete privata.

I firewall possono essere implementati sia in hardware che software. Generalmente

si mette un firewall tra la macchina o la rete da proteggere e la rete esterna.

Esistono diversi tecniche di firewall. Filtro

dei pacchetti: Controlla ogni singolo pacchetto

e applica le regole di filtraggio definite dall'utente, che in genere sono

del tipo: "blocca

tutti i pacchetti provenienti da qualsiasi indirizzo, destinati a una particolare

macchina o range di indirizzi sulla porta xxxx".

A livello di applicazione:

Vengono controllati solo determinate applicazioni come i server FTP,

Telnet, etc. A livello di

connessione: Vengono testate solo le connessioni

e una volta stabilite, non vengono più effettuati altri controlli.

Server proxy:

Simile al filtro dei pacchetti, ma nasconde gli indirizzi delle macchine

da proteggere, e non è trasparente come il primo. In altre parole

necessita di configurazioni particolari delle applicazioni come il browser

o client ftp, che per comunicare con l'esterno devono indirizzare

le richieste al proxy.].

Se è stato installato un AntiSpam

-normalmente uno dei più diffusi è Norton-, è

conveniente disattivarlo. Infatti il filtro

antispam -nella navigazione WEB-, non solo

rallenta il DOWNLOAD delle pagine, ma può determinare

una non corretta visualizzazione delle .GIF -molto spesso

quelle animate- e una non visualizzazione di alcune immagini .JPG

di grandi dimensioni. L'operazione non è copmlessa; bastano

alcuni click per disattivare o riattivare l'AntiSpam.

La scheda grafica deve essere almeno 64 Mb --

infatti, se si dispone di una connessione veloce ma una scheda grafica inferiore

a 64 Mb -ciò implica anche una minore velocità

della CPU ad essa dedicata ed altre cose tecniche

nelle quali non mi addentro- si ha, come principale sintomo, un rallentamento

dello scrolling [alto-basso]

di pagina rischiando, nella peggiore delle ipotesi, il blocco

del sistema. La cache memory del sistema deve

esserere almeno 512 Mb. Può andar bene anche una

cache memory di 256 Mb, ma in questo caso,

si consiglia -vivamente- di chiudere alcuni programmi che

girano in back-ground e di cercare di aprire -se è

possibile- il minor numero di finestre del browser -o di

applicazioni [applicazione

= finalità specifica a cui è dedicato

un programma o un sistema di elaborazione]-,

durante la navigazione; infatti, una apertura forsennata di applicazioni

può verificare -in condizioni particolari, sulle quali non mi

dilungo ulteriormente- un over-flow di memoria anche

nel caso in cui la R.A.M. -in uso- sia molto robusta. Potete

usare questa pagina, come TEST

per valutare se il vostro sistema ha le caratteristiche richieste per poter

continuare nella navigazione.--. Si consiglia di aggiornare DirectX

all'ultima realise. Si consiglia, inoltre, di aggiornare -se possibile-

il DRIVER della scheda grafica in uso. La cache

dell'Internet temporary file

deve essere configurata almeno a qualche Giga, se la velocità di connessione

è bassa. Questo serve per non continuare a ricaricare immagini, filmati,

FLASH ecc. rivisitando una stessa pagina.. La velocità

di connessione minima, deve essere: ISDN

64+64 = 128 Kb/s o, --ottimale--,

ADSL a

640 Kb/s o superiore. La memoria RAM

del sistema deve essere almeno 128 Mb (DDRAM).

Sarebbe meglio disporre di un programma

di RAM defrag -per farlo girare in background,

con campionamento risorse a bassa frequenza e possibilità di defrag manuale

over xxx Mb RAM-. Una FACILITY

molto interessante per la didattica --mi riferisco

alla fase di apprendimento-- è la seguente; la possibilità

di disporre di un PLUG-IN per la

sintesi VOCALE. In altre parole, la lettura di un TESTO,

con voce sintetica, usufruendo della semplice procedura copia+incolla.

Il PLUG-IN al quale mi riferisco è MyVoice.

Per scaricare questo "ausilio

didattico", cliccare [QUI].

Una volta installato il PLUG-IN, per poter effettuare la

lettura dei testi -in lingua italiana- selezionati nel sito, cliccare

[QUI].

Fatto il copia+incolla sulla finestra di "dialogo",

cliccare su "Leggi".

Il programma di sintesi VOCALE

è molto intuitivo. Per quanto riguarda i collegamenti alle pagine

del sito, questi sono strutturati in LINK+(argomento)+New+ .

L'argomento, tra parentesi

tonda, descrive l'ultimo argomento trattato nella pagina a cui ci si vuol

linK-are. Se l'argomento è di nuova stesura, vi è la parola New

-dopo la parentesi-. New

permane per circa una settimana --nella pagina principale del sito; pagina

di index--; poi viene cancellato. New,

però, rimane

nella sotto-pagina di contesto, fino a nuovo argomento

di stesura. Se il collegamento alla pagina a cui ci si vuol linK-are è

seguito da

.

L'argomento, tra parentesi

tonda, descrive l'ultimo argomento trattato nella pagina a cui ci si vuol

linK-are. Se l'argomento è di nuova stesura, vi è la parola New

-dopo la parentesi-. New

permane per circa una settimana --nella pagina principale del sito; pagina

di index--; poi viene cancellato. New,

però, rimane

nella sotto-pagina di contesto, fino a nuovo argomento

di stesura. Se il collegamento alla pagina a cui ci si vuol linK-are è

seguito da  ,

vuol dire che, pur restando i contenuti della stessa invariati, c'è

stata una mia revisione; correzione di alcuni errori di battitura, creazione

di nuovi LINK -- ancoraggi

nella pagina, in altre pagine del sito o extra-sito

[i LINK extra-sito, vengono

controllati ogni 6 mesi per verificare la loro esistenza

nel WEB]--

o aggiunta di qualche FACILITY ecc.. E'

ovvio che in questo caso non compare New

sul LINK. --

In sostanza vi è stata una revisione della pagina;

,

vuol dire che, pur restando i contenuti della stessa invariati, c'è

stata una mia revisione; correzione di alcuni errori di battitura, creazione

di nuovi LINK -- ancoraggi

nella pagina, in altre pagine del sito o extra-sito

[i LINK extra-sito, vengono

controllati ogni 6 mesi per verificare la loro esistenza

nel WEB]--

o aggiunta di qualche FACILITY ecc.. E'

ovvio che in questo caso non compare New

sul LINK. --

In sostanza vi è stata una revisione della pagina;  permane per circa una settimana.-- Ogni pagina è munita di un comando

di [RELOAD],

per permettere di ricaricarla, nel caso in cui alcune immagini non siano

state visualizzate correttamente. La non visulizzazione di tali immagini,

è determinata da una velocità di connessione,

non compatibile con alcune pagine WEB,

di grandi dimensioni. L'impostazione

del sito è di tipo classico -un enorme contenitore iper-testuale con

un grado molto alto in multimedialità-. Non si è data molta

importanza alla veste grafica, ma ai contenuti. La bella veste grafica è

lasciata ai siti .com. E'

in preparazione la MAPPA LOGICA

del sito. Probabilmente, con essa, sarà compresa la finalità del sito stesso

-che ha come punto di partenza l'Asimmetria materia ed

antimateria- Dai vari argomenti trattati -e che verranno trattati

in futuro- si può già intravvedere come la COSMOLOGIA

sia per sua natura multi-disciplinare. -- 200 Mb di spazio

WEB penso possa bastare, per

il momento. Se non dovesse essere sufficiente -in futuro-,

amplierò ulteriormente -a 25 Mb per volta- tale

spazio. --. Il WEBMASTER alias

CHANDRAst... [Memoranda

per configurazione

Esecuzione Automatica: FreeMempro,

SpySwepper, QuickTime Task, ScanRegistry, TaskMonitor,

PCHealth, Zone Labs Client, VirusScan Online, VSOCheck Task, MCAgentExe,

MCUpdateEXE, MPFExe, MPSExe, McVsRte, TrueVector, ccRegVfy,

ccEvtMgr, Nisum, ccPxySvc,

SchedulingAgent. Host

I.P.: 127.0.0.1,

HacKers Shield]. Il

sito è in OPEN-SOURCE;

qualsiasi parte può venire copiata e/o pubblicata e diffusa con qualsiasi

Mass Media.

-fermo restando che se vi è diffusione di immagini, filmati o

parti scritte protette da copyright, queste DEVONO

essere necessariamente diffuse citando la fonte di provenienza e avvisando

che vi è copyright !!- . Per

maggiori dettagli, contattatemi al cell.:

3473027865 (Vodafone)...

AVVISO: La maggior parte degli

permane per circa una settimana.-- Ogni pagina è munita di un comando

di [RELOAD],

per permettere di ricaricarla, nel caso in cui alcune immagini non siano

state visualizzate correttamente. La non visulizzazione di tali immagini,

è determinata da una velocità di connessione,

non compatibile con alcune pagine WEB,

di grandi dimensioni. L'impostazione

del sito è di tipo classico -un enorme contenitore iper-testuale con

un grado molto alto in multimedialità-. Non si è data molta

importanza alla veste grafica, ma ai contenuti. La bella veste grafica è

lasciata ai siti .com. E'

in preparazione la MAPPA LOGICA

del sito. Probabilmente, con essa, sarà compresa la finalità del sito stesso

-che ha come punto di partenza l'Asimmetria materia ed

antimateria- Dai vari argomenti trattati -e che verranno trattati

in futuro- si può già intravvedere come la COSMOLOGIA

sia per sua natura multi-disciplinare. -- 200 Mb di spazio

WEB penso possa bastare, per

il momento. Se non dovesse essere sufficiente -in futuro-,

amplierò ulteriormente -a 25 Mb per volta- tale

spazio. --. Il WEBMASTER alias

CHANDRAst... [Memoranda

per configurazione

Esecuzione Automatica: FreeMempro,

SpySwepper, QuickTime Task, ScanRegistry, TaskMonitor,

PCHealth, Zone Labs Client, VirusScan Online, VSOCheck Task, MCAgentExe,

MCUpdateEXE, MPFExe, MPSExe, McVsRte, TrueVector, ccRegVfy,

ccEvtMgr, Nisum, ccPxySvc,

SchedulingAgent. Host

I.P.: 127.0.0.1,

HacKers Shield]. Il

sito è in OPEN-SOURCE;

qualsiasi parte può venire copiata e/o pubblicata e diffusa con qualsiasi

Mass Media.

-fermo restando che se vi è diffusione di immagini, filmati o

parti scritte protette da copyright, queste DEVONO

essere necessariamente diffuse citando la fonte di provenienza e avvisando

che vi è copyright !!- . Per

maggiori dettagli, contattatemi al cell.:

3473027865 (Vodafone)...

AVVISO: La maggior parte degli utenti sa destreggiarsi bene con concetti come freeware,

shareware, cookies, lettori multimediali,

contenuti interattivi e condivisione di file. Ciò che forse non tutti

sanno però è che alcuni di questi elementi possono contenere

codici o componenti che consentono agli sviluppatori di questi strumenti

e applicazioni di raccogliere e diffondere informazioni relative ai loro

utilizzatori

--

non è il caso di questo sito --.

Essi possono infatti registrare le preferenze dei siti visitati dall'utente

e inviare queste informazioni a terzi, nonché prendere nota delle

preferenze relative ai suoi acquisti online, ridefinire la pagina iniziale

del suo browser, alterare importanti file di sistema; tutto questo, senza

che l'utente se ne accorga. Le implicazioni di questo tipo di operazioni

sul piano della sicurezza e della privacy

sono ovvie e certamente indesiderate per qualsiasi sistema o rete. Non sarebbe

male disporre di uno SPY per

eliminare tali problemi. Consiglio di scaricare la versione free di

Ad-Aware Se Personal

>>[Software

Publisher's Description: With

the ability to scan your RAM, registry, hard drives, and

external storage devices for known data-mining, advertising, and tracking

components, Ad-aware SE easily can clean your system, allowing

you to maintain a higher degree of privacy while you surf the Web.

Ad-Aware SE Personal

Edition boasts a number of improvements. Extended memory

scanning now scans all modules loaded by a process. Scanning uses the all-

new CSI (Code

Sequence Identification)

technology to identify new and unknown variants of known targets. Extended

registry scanning now scans registry branches of multiple-user accounts

and performs additional smart checks to detect dynamically created references.

Scanning speed is noticeably faster, and this version offers an Extended

Scanning mode for known and unknown/possible

browser hijackers.]<<

utenti sa destreggiarsi bene con concetti come freeware,

shareware, cookies, lettori multimediali,

contenuti interattivi e condivisione di file. Ciò che forse non tutti

sanno però è che alcuni di questi elementi possono contenere

codici o componenti che consentono agli sviluppatori di questi strumenti

e applicazioni di raccogliere e diffondere informazioni relative ai loro

utilizzatori

--

non è il caso di questo sito --.

Essi possono infatti registrare le preferenze dei siti visitati dall'utente

e inviare queste informazioni a terzi, nonché prendere nota delle

preferenze relative ai suoi acquisti online, ridefinire la pagina iniziale

del suo browser, alterare importanti file di sistema; tutto questo, senza

che l'utente se ne accorga. Le implicazioni di questo tipo di operazioni

sul piano della sicurezza e della privacy

sono ovvie e certamente indesiderate per qualsiasi sistema o rete. Non sarebbe

male disporre di uno SPY per

eliminare tali problemi. Consiglio di scaricare la versione free di

Ad-Aware Se Personal

>>[Software

Publisher's Description: With

the ability to scan your RAM, registry, hard drives, and

external storage devices for known data-mining, advertising, and tracking

components, Ad-aware SE easily can clean your system, allowing

you to maintain a higher degree of privacy while you surf the Web.

Ad-Aware SE Personal

Edition boasts a number of improvements. Extended memory

scanning now scans all modules loaded by a process. Scanning uses the all-

new CSI (Code

Sequence Identification)

technology to identify new and unknown variants of known targets. Extended

registry scanning now scans registry branches of multiple-user accounts

and performs additional smart checks to detect dynamically created references.

Scanning speed is noticeably faster, and this version offers an Extended

Scanning mode for known and unknown/possible

browser hijackers.]<<

IMPORTANTE:

Il sito è stato progettato per una risoluzione grafica 1152

x 864 pixel. Tutte le pagine

sono visibili -correttamente-

anche con risoluzione 1024 x 768

pixel.

ALCUNE VISITE ECCELLENTI...

[X]-Salta presentazione. (Vai subito alla MAPPA della PAGINA)...

About my job...

The subjects: I have been working on aree:

Cosmology; statistics of the cosmic

statistics of the cosmic  microwave

background fluctuations, in particular I am part of the

WMAP science

team; use of higher order correlations in cosmology; nature of the primordial

fluctuations: the initial conditions for cosmological structure formation;

clusters scaling relations; statistical analysis of large-scale

structure; relationship between the clustering properties

of visible matter and of the dark

matter; problems for CDM:

galaxy cusps and dwarf

galaxies. I have been working on BOREXino

experiment at "Laboratori

Nazionali del GranSasso"

(LNGS),

in particular to study the Solar neutrino

problem, neutrino magnetic moment, double beta decay,

cosmological implications,

etc.; Today, I'm working on AURIGA

experiment at Legnaro -INFN Padova- and Elettra

-Trieste-. I'm a part of the IRA science

team (Istituto di RadioAstronomia)

-Stazione di Medicina- Bologna - CNR- to study

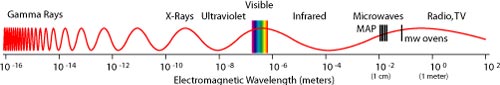

H2O MASER sources....[COSMIC

MASER: Some nebular regions

and stellar atmospheres emit intensely in the microwaves. Such cancellation

is generated from effect maser, that it is the equivalent for the microwaves

of the effect laser for the visible one.].

Currently I

am interested

microwave

background fluctuations, in particular I am part of the

WMAP science

team; use of higher order correlations in cosmology; nature of the primordial

fluctuations: the initial conditions for cosmological structure formation;

clusters scaling relations; statistical analysis of large-scale

structure; relationship between the clustering properties

of visible matter and of the dark

matter; problems for CDM:

galaxy cusps and dwarf

galaxies. I have been working on BOREXino

experiment at "Laboratori

Nazionali del GranSasso"

(LNGS),

in particular to study the Solar neutrino

problem, neutrino magnetic moment, double beta decay,

cosmological implications,

etc.; Today, I'm working on AURIGA

experiment at Legnaro -INFN Padova- and Elettra

-Trieste-. I'm a part of the IRA science

team (Istituto di RadioAstronomia)

-Stazione di Medicina- Bologna - CNR- to study

H2O MASER sources....[COSMIC

MASER: Some nebular regions

and stellar atmospheres emit intensely in the microwaves. Such cancellation

is generated from effect maser, that it is the equivalent for the microwaves

of the effect laser for the visible one.].

Currently I

am interested  in

the following fields of research:

astrophysical and computational fluid mechanics, in particular; radio

galaxies, galaxy clusters, cooling

flows [Cooling flows:

The gas permeating clusters of galaxies often shows a

peak in the X-ray surface brightness which is interpreted

as evidence for a cooling flow. In the picture of a cooling flow radiative

cooling in the central regions of a cluster causes a slow subsonic inflow

of gas which deposits mass at a rate of 10-1000 solar masses/yr.

However, searches in all wavebands for the cooled material have revealed

significantly less gas than predicted. The X-ray observatories

Chandra and XMM have shown that the

spectra from cooling flow regions show a remarkable lack of emission lines

from gas with a temperature below about 1 keV. At the

same time it has been noted that cooling flow clusters often host strong

radio sources at their centres. These radio sources inflate large bubbles

of hot plasma that subsequently rise through the cluster atmosphere, thus

mixing and stirring the cluster atmosphere.],

radio relics [Radio

Relics: The jets of powerful radio galaxies

inflate large cavities in the IGM that are filled with

relativistic particles and magnetic fields. Synchrotron emission at radio

frequencies reveals the presence of electrons with energies of the order

of GeVs. These electrons have radiative lifetimes of

the order of 100 Myr before radiative losses cause their

radio emission to fade until they can no longer be observed. The remnants

of radio galaxies and quasars are called 'fossil

radio plasma' or

a 'radio ghosts'.

For some years now, astronomers have observed faint, extended radioemission

that cannot be linked to any nearby galaxy. Several ofthese mysterious

objects have been observed and they have been called radio relics.

The so-called cluster radio relics

are typically located near the periphery of the cluster; they often exhibit

sharp emission edges and many of them show strong radio polarisation.

It has also been noted that the location of some radio relics coincide

with the location of shock waves that are produced by collisions between

clusters of galaxies.],

helioseismology

[Helioseismology:

Another very important area of research

is developing techniques to analyse solar oscillations. Helioseismology

investigates the internal structure of the Sun by studying

the oscillations of the solar surface. Using theories for wave propagation

in turbulent media, I have studied the interaction of sound waves with

the turbulence in the solar convection zone. The sound waves are scattered

by the turbulent eddies in the solar convection region causing temporal

fluctuations of the cross-correlation signal between two points on the

solar surface. Hence one could probe, both, the strength and the scaling

of the convection by measuring the variation in the correlation. By examining

wave paths of different lengths, fluctuations on several different scales

can be addressed. By using wavepaths that penetrate to greater and greater

depths the spatial variation of turbulence can be studied and one can

search for latitudinal variations of the convection. The ultimate goal

would be to invert the scintillation of the correlation function for the

structure of the turbulence beneath the solar surface. A related research

area which I am actively involved in is time-distance seismology of sunspots.

Only recently, with the advent of new instruments allowing observations

of high spatial resolution, has it become possible to study oscillations

locally. When two distinct points on the solar surface are cross-correlated

it is found that the cross-correlation is maximal for a certain time lag

which is identified with the time a disturbance takes to travel from the

one point to the other. Subsurface flows and active regions such as sunspots

alter the travel time of waves with respect to the quiet sun and could

thus be detected seismically. I am developing an asymptotic theory

on how to interpret the seismic signatures of these active regions.]

,space plasma research.

I am developing algorithms that will efficiently

and accurately group similar images in a database. We are using over 150

ROSAT X-ray

images of galaxy clusters as the “test

bed”. X-ray images of galaxy

clusters have a variety of morphologies that reflect the specific

evolutionary point in the formation of the cluster. For

example, a bimodal system in which

two cluster components have nearly equal luminosity, separation of less

than 3 million light years, and nearly circular

shape represents a distinct pre-merger epoch of cluster evolution that

is seen in Cold Dark Matter and related hydrodynamic

[Hydrodynamical Simulations:

With the advent of powerful computers and more accurate

algorithms, simulations of astrophysical fluids have become increasingly

useful. Most fields of astrophysics, such as solar physics, star formation,

stellar evolution and cosmology have benefitted greatly from hydrodynamical

simulations and hopes for further advances are high. Essentially,

there are two main approaches to the numerical solution of the equations

of hydrodynamics:

Finite-grid simulations and Smoothed Particle

Hydrodynamics (SPH).

In the former approach the equations are discretised on a computational

mesh before they are solved. The latter method avoids the notion of a

mesh and employs particles to track the fluid. Both methods have different

strengths and weaknesses but we are mostly concerned with grid-based codes.

These have proven especially useful for discontinuous flows where shock-capturing

advection schemes yield much greater accuracy than SPH codes.

Moreover, it is generally easier to add more physics such as magnetic

fields or radiation to the grid-based codes than to SPH codes.

One of the main challenges in the simulation of astrophysical fluids is

to bridge the gap between the simulation of the mascroscopic flow and

different microphysical processes, such as nuclear reactions,

X-ray and radio emission, just to name

a few. The scales of the macroscopic flow and the microphysical processes

are separated by many orders of magnitude, yet both 'worlds' are tightly

interlinked. Many problems in numerical hydrodynamics require a high resolution

in order to describe the evolution of the system accurately enough. In

turn, the use of large grids implies high demands in terms of both, computer

memory and CPU time. One numerical technique which has been developed

to increase the efficiency of these finite-difference simulations is the

method of adaptive mesh refinement (AMR).

In these codes the computational grid is continually adapted to the flow

and resolution elements are only placed where they are needed. One of

the most challenging problems in computational science to which AMR

is being applied is numerical modeling of combustion. Calculations of

combustion processes often include a well-defined flame front; focusing

the computing power on the flame, where hundreds or thousands of chemical

reactions may be taking place, results in large savings in computing time

and memory. As the flame develops and moves through the domain, the finer

meshes automatically move with it, allowing researchers to achieve unprecedented

temporal and spatial resolution of the internal flame structure.],

n-body simulations of the Universe.

I investigate the nature of

the point-like optical nuclei that have been found in

the centres of the host galaxies of a majority of radio

galaxies by the Hubble Space Telescope.

I examine the evidence that these optical nuclei are relativistically

beamed, and look for differences in the behaviour of the nuclei found

in radio galaxies of the two Fanaroff-Riley types.

I also attempt to relate this behaviour to the properties of the optical

nuclei in their highly beamed counterparts (the

BL Lac objects and radio-loud quasars)

as hypothesized by the simple Unified Scheme. Simple

model-fitting of the data suggests that the emission may be coming from

a non-thermal relativistic jet. It is also suggestive

that the contribution from an accretion disk is not significant for the

FRI objects and for the narrow-line radio galaxies of

FRII type, while it may be significant for the Broad-line

objects, and consistent with the idea that the FRII optical

nuclei seem to suffer from extinction due to an obscuring torus

while the FRI optical nuclei do not. These results are

broadly in agreement with the Unified Scheme for radio-loud AGNs.

The life is strange...

my surname is collected and placed on the STARDUST

spacecraft, which visited Comet

Wild 2 in January 2, 2004...

It is nice ;-) In

fact a relative of mine has fought in Vietnam. He died

on the battlefield with honor. Let

me remeber a Irish song: "[...]

I wait here in this hole Playing poker

with my soul. I hold the rifle close to me, It lights the way to keep

me free. If I die in a combat zone, Box me up and ship me home. If I die

and still come home, Lay me where the rose is sown. Sons of men who stand

like gods, We give life to feed the cause, And run to ground our heathen

foe, Our name will never die. This time will be forever.[...]".

The chip name, placed and collected, never die. [Stardust

has traveled about 3.22 billion kilometers (2

billion miles) since its launch

on February 7, 1999. As

it closed the final gap with its cometary quarry, it endured a bombardment

of particles surrounding the nucleus of comet

Wild 2.]

in

the following fields of research:

astrophysical and computational fluid mechanics, in particular; radio

galaxies, galaxy clusters, cooling

flows [Cooling flows:

The gas permeating clusters of galaxies often shows a

peak in the X-ray surface brightness which is interpreted

as evidence for a cooling flow. In the picture of a cooling flow radiative

cooling in the central regions of a cluster causes a slow subsonic inflow

of gas which deposits mass at a rate of 10-1000 solar masses/yr.

However, searches in all wavebands for the cooled material have revealed

significantly less gas than predicted. The X-ray observatories

Chandra and XMM have shown that the

spectra from cooling flow regions show a remarkable lack of emission lines

from gas with a temperature below about 1 keV. At the

same time it has been noted that cooling flow clusters often host strong

radio sources at their centres. These radio sources inflate large bubbles

of hot plasma that subsequently rise through the cluster atmosphere, thus

mixing and stirring the cluster atmosphere.],

radio relics [Radio

Relics: The jets of powerful radio galaxies

inflate large cavities in the IGM that are filled with

relativistic particles and magnetic fields. Synchrotron emission at radio

frequencies reveals the presence of electrons with energies of the order

of GeVs. These electrons have radiative lifetimes of

the order of 100 Myr before radiative losses cause their

radio emission to fade until they can no longer be observed. The remnants

of radio galaxies and quasars are called 'fossil

radio plasma' or

a 'radio ghosts'.

For some years now, astronomers have observed faint, extended radioemission

that cannot be linked to any nearby galaxy. Several ofthese mysterious

objects have been observed and they have been called radio relics.

The so-called cluster radio relics

are typically located near the periphery of the cluster; they often exhibit

sharp emission edges and many of them show strong radio polarisation.

It has also been noted that the location of some radio relics coincide

with the location of shock waves that are produced by collisions between

clusters of galaxies.],

helioseismology

[Helioseismology:

Another very important area of research

is developing techniques to analyse solar oscillations. Helioseismology

investigates the internal structure of the Sun by studying

the oscillations of the solar surface. Using theories for wave propagation

in turbulent media, I have studied the interaction of sound waves with

the turbulence in the solar convection zone. The sound waves are scattered

by the turbulent eddies in the solar convection region causing temporal

fluctuations of the cross-correlation signal between two points on the

solar surface. Hence one could probe, both, the strength and the scaling

of the convection by measuring the variation in the correlation. By examining

wave paths of different lengths, fluctuations on several different scales

can be addressed. By using wavepaths that penetrate to greater and greater

depths the spatial variation of turbulence can be studied and one can

search for latitudinal variations of the convection. The ultimate goal

would be to invert the scintillation of the correlation function for the

structure of the turbulence beneath the solar surface. A related research

area which I am actively involved in is time-distance seismology of sunspots.

Only recently, with the advent of new instruments allowing observations

of high spatial resolution, has it become possible to study oscillations

locally. When two distinct points on the solar surface are cross-correlated

it is found that the cross-correlation is maximal for a certain time lag

which is identified with the time a disturbance takes to travel from the

one point to the other. Subsurface flows and active regions such as sunspots

alter the travel time of waves with respect to the quiet sun and could

thus be detected seismically. I am developing an asymptotic theory

on how to interpret the seismic signatures of these active regions.]

,space plasma research.

I am developing algorithms that will efficiently

and accurately group similar images in a database. We are using over 150

ROSAT X-ray

images of galaxy clusters as the “test

bed”. X-ray images of galaxy

clusters have a variety of morphologies that reflect the specific

evolutionary point in the formation of the cluster. For

example, a bimodal system in which

two cluster components have nearly equal luminosity, separation of less

than 3 million light years, and nearly circular

shape represents a distinct pre-merger epoch of cluster evolution that

is seen in Cold Dark Matter and related hydrodynamic

[Hydrodynamical Simulations:

With the advent of powerful computers and more accurate

algorithms, simulations of astrophysical fluids have become increasingly

useful. Most fields of astrophysics, such as solar physics, star formation,

stellar evolution and cosmology have benefitted greatly from hydrodynamical

simulations and hopes for further advances are high. Essentially,

there are two main approaches to the numerical solution of the equations

of hydrodynamics:

Finite-grid simulations and Smoothed Particle

Hydrodynamics (SPH).

In the former approach the equations are discretised on a computational

mesh before they are solved. The latter method avoids the notion of a

mesh and employs particles to track the fluid. Both methods have different

strengths and weaknesses but we are mostly concerned with grid-based codes.

These have proven especially useful for discontinuous flows where shock-capturing

advection schemes yield much greater accuracy than SPH codes.

Moreover, it is generally easier to add more physics such as magnetic

fields or radiation to the grid-based codes than to SPH codes.

One of the main challenges in the simulation of astrophysical fluids is

to bridge the gap between the simulation of the mascroscopic flow and

different microphysical processes, such as nuclear reactions,

X-ray and radio emission, just to name

a few. The scales of the macroscopic flow and the microphysical processes

are separated by many orders of magnitude, yet both 'worlds' are tightly

interlinked. Many problems in numerical hydrodynamics require a high resolution

in order to describe the evolution of the system accurately enough. In

turn, the use of large grids implies high demands in terms of both, computer

memory and CPU time. One numerical technique which has been developed

to increase the efficiency of these finite-difference simulations is the

method of adaptive mesh refinement (AMR).

In these codes the computational grid is continually adapted to the flow

and resolution elements are only placed where they are needed. One of

the most challenging problems in computational science to which AMR

is being applied is numerical modeling of combustion. Calculations of

combustion processes often include a well-defined flame front; focusing

the computing power on the flame, where hundreds or thousands of chemical

reactions may be taking place, results in large savings in computing time

and memory. As the flame develops and moves through the domain, the finer

meshes automatically move with it, allowing researchers to achieve unprecedented

temporal and spatial resolution of the internal flame structure.],

n-body simulations of the Universe.

I investigate the nature of

the point-like optical nuclei that have been found in

the centres of the host galaxies of a majority of radio

galaxies by the Hubble Space Telescope.

I examine the evidence that these optical nuclei are relativistically

beamed, and look for differences in the behaviour of the nuclei found

in radio galaxies of the two Fanaroff-Riley types.

I also attempt to relate this behaviour to the properties of the optical

nuclei in their highly beamed counterparts (the

BL Lac objects and radio-loud quasars)

as hypothesized by the simple Unified Scheme. Simple

model-fitting of the data suggests that the emission may be coming from

a non-thermal relativistic jet. It is also suggestive

that the contribution from an accretion disk is not significant for the

FRI objects and for the narrow-line radio galaxies of

FRII type, while it may be significant for the Broad-line

objects, and consistent with the idea that the FRII optical

nuclei seem to suffer from extinction due to an obscuring torus

while the FRI optical nuclei do not. These results are

broadly in agreement with the Unified Scheme for radio-loud AGNs.

The life is strange...

my surname is collected and placed on the STARDUST

spacecraft, which visited Comet

Wild 2 in January 2, 2004...

It is nice ;-) In

fact a relative of mine has fought in Vietnam. He died

on the battlefield with honor. Let

me remeber a Irish song: "[...]

I wait here in this hole Playing poker

with my soul. I hold the rifle close to me, It lights the way to keep

me free. If I die in a combat zone, Box me up and ship me home. If I die

and still come home, Lay me where the rose is sown. Sons of men who stand

like gods, We give life to feed the cause, And run to ground our heathen

foe, Our name will never die. This time will be forever.[...]".

The chip name, placed and collected, never die. [Stardust

has traveled about 3.22 billion kilometers (2

billion miles) since its launch

on February 7, 1999. As

it closed the final gap with its cometary quarry, it endured a bombardment

of particles surrounding the nucleus of comet

Wild 2.]

clicca sui collegamenti per osservare la posizione della cometa WILD-2. |

|

Before the Stardust spacecraft's successful encounter with comet Wild 2 on January 2, JPL mission navigator Dr. Shyam Bhaskaran gave a preview of the navigation know-how required for such a mission.

| WMAP Overview |

The WMAP (Wilkinson Microwave Anisotropy Probe) mission is designed to determine the geometry, content, and evolution of the universe via a 13 arcminute FWHM resolution full sky map of the temperature anisotropy of the cosmic microwave background radiation. The choice of orbit, sky-scanning strategy and instrument/spacecraft design were driven by the goals of uncorrelated pixel noise, minimal systematic errors, multifrequency observations, and accurate calibration. The skymap data products derived from the WMAP observations have 45 times the sensitivity and 33 times the angular resolution of the COBE DMR mission. The WMAP mission characteristics are summarized in the table below.

| WMAP Mission Characteristics: | |||||

| K-Banda | Ka-Banda | Q-Banda | V-Banda | W-Banda | |

| Wavelength (mm)b | 13 | 9.1 | 7.3 | 4.9 | 3.2 |

| Frequency (GHz)b | 23 | 33 | 41 | 61 | 94 |

| Bandwidth (GHz)b, c | 5.5 | 7.0 | 8.3 | 14.0 | 20.5 |

| Number of Differencing Assemblies | 1 | 1 | 2 | 2 | 4 |

| Number of Radiometers | 2 | 2 | 4 | 4 | 8 |

| Number of Channels | 4 | 4 | 8 | 8 | 16 |

| Beam size (deg)b, d | 0.88 | 0.66 | 0.51 | 0.35 | 0.22 |

| System temperature, Tsys (K)b, e | 29 | 39 | 59 | 92 | 145 |

| Sensitivity (mK sec½ )b | 0.8 | 0.8 | 1.0 | 1.2 | 1.6 |

| Sky coverage | Full sky |

| Optical system | Back-to-Back Gregorian, 1.4 x 1.6 m primaries |

| Radiometric system | differential polarization sensitive receivers |

| Detection | HEMT amplifiers |

| Radiometer Modulation | 2.5 kHz phase switch |

| Spin Modulation | 0.464 rpm = ~ 7.57 mHz spacecraft spin |

| precession Modulation | 1 rev hr -1 = ~ 0.3 mHz spacecraft precession |

| Calibration | In-flight: amplitude from dipole modulation, beam from Jupiter |

| Cooling system | passively cooled to ~ 90 K |

| Attitude control | 3-axis controlled, 3 wheels, gyros, star trackers, sun sensors |

| Propulsion | blow-down hydrazine with 8 thrusters |

| RF communication | 2 GHz transponders, 667 kbps down-link to 70 m DSN |

| Power | 419 Watts |

| Mass | 840 kg |

| Launch | Delta II 7425-10 on June 30, 2001 at 3:46:46.183 EDT |

| Orbit | 1° - 10° Lissajous orbit about second Lagrange point, L2 |

| Trajectory | 3 Earth-Moon phasing loops, lunar gravity assist to L2 |

| Design Lifetime | 27 months = 3 month trajectory + 2 yrs at L2 |

a

Commercial waveguide band designations used for the five MAP

frequency bands |

||

b Typical values

for a radiometer are given. |

||

c Effective signal

bandwidth. |

||

| d The beam patterns are not Gaussian, and thus are not simply specified. The size given here is the square- root of the beam solid angle. | ||

| e Effective system temperature of the entire system. |

| L'antenna per onde gravitazionali AURIGA |

Una attività sviluppata presso i Laboratori Nazionali di Legnaro, di argomento non legato alla fisica del nucleo, è la ricerca di onde gravitazionali con l'apparato AURIGA (Antenna Ultracriogenica Risonante per l'Indagine Gravitazionale Astronomica). AURIGA è un'antenna gravitazionale installata nei Laboratori, e appartiene all'ultima generazione di antenne ultracriogeniche raffreddate a circa un decimo di grado Kelvin. Il criostato è composto da contenitori concentrici via via più freddi dall'esterno all'interno, dove si trova l'antenna cilindrica di alluminio, del peso di 3 tonnellate. I contenitori sono appesi l'uno all'altro con cavi in modo da isolare l'antenna dalle vibrazioni meccaniche dell'ambiente esterno. Un trasduttore elettromeccanico converte l'energia vibrazionale meccanica in un segnale elettrico, a sua volta accoppiato ad uno SQUID, che funziona da preamplificatore. L'antenna, può rivelare il tempo di arrivo dell'impulso energetico gravitazionale con una risoluzione di meno di 100 µs, rivelelando impulsi di onde gravitazionali come quelle originate da supernove di tipo II, o dalla fase finale della coalescenza di sistemi binari di stelle di neutroni.

NOTA: L'attività di ricerca è principalmente focalizzata su esperimenti volti alla rivelazione delle onde gravitazionali. Il Gruppo contribuisce allo sviluppo, alla realizzazione a al funzionamento di rivelatori di onde gravitazionali, sia basati a terra che spaziali: disegno dell'interferometro LISA, missione congiunta ESA/NASA, e sviluppo della tecnologia rilevante (sensori inerziali), disegno del dimostratore in volo della tecnologia di LISA (LTP) che volerà a bordo della missione spaziale SMART-2, per il quale il gruppo ha responsabilità di Principal Investigator (LISA technology package architect sotto contratto ESA). Funzionamento e miglioramento del rivelatore criogenico a barra risonante AURIGA e ricerca e sviluppo su rivelatori acustici innovativi a larghissima banda. Lo sviluppo di sistemi quali sensori ed amplificatori a bassissimo rumore è connesso con studi sulle fluttuazioni termodinamiche e quantistiche in sistemi di materia condensata e con le limitazioni che questi fenomeni impongono ad esperimenti di fisica fondamentale.

MAPPA della PAGINA: Asimmetria materia-antimateria... Agg. 22.06.2004

ASIMMETRIA MATERIA-ANTIMATERIA

[X]-Clicca sulla X per avere la versione intergrale del testo scorrevole.

E' noto che nel brodo primordiale particelle ed antiparticelle esistessero in uno stesso numero, senza che ce ne fosse un tipo privilegiato. Ma quando la temperatura a cominciato a scendere cos'è stato a privilegiare la materia sull'antimateria ?

Questa domanda coinvolge direttamente uno dei campi di ricerca più attivi, attuali ed interessanti della fisica moderna. Premettendo che non esiste a tuttoggi una risposta completa ed esaustiva al quesito, cercherò di fare una breve ed "incompleta" panoramica: un'analisi accurata richiederebbe conoscenze di fisica delle alte energie e cosmologia che esulano (per il momento -al 16.07.2004- questa chiarificazione, può essere omessa, dato che il sito ha superato, di molto, le aspettative tecnico-divulgative poste in essere ne primi giorni del secolo corso -2000 a.D. -.) dagli obbiettivi del sito.

1)-Asimmetria Barionica. Asimmetria di materia su antimateria significa preponderanza di barioni su antibarioni. Quella dei barioni è la famiglia delle particelle di cui fanno parte protoni e neutroni. Occorre sottolineare che non è dato per scontato che ci sia più materia che antimateria nell' universo. Nelle vicinanze della Terra non ci sono dubbi: la materia domina. La Luna ed il sistema solare sono fatti di (quella che noi chiamiamo) materia, infatti uomini e sonde mandate in esplorazione di questi astri non sono spariti per annichilazione. La nostra GALASSIA è quasi certamente fatta di materia, come inficiamo dalla composizione dei raggi cosmici di origine galattica. Per galassie lontane non c'è prova diretta. L'osservazione della radiazione emessa non dice nulla: i fotoni sono esattamente uguali agli antifotoni (il fotone è l'antiparticella di se stesso). Quindi l'uso del telescopio spaziale non aiuta a capire se l'universo lontano o parti di esso siano costituiti da materia o antimateria. Tuttavia, ci sono vari elementi che, più o meno indirettamente, portano ad escludere lo scenario in cui esistono parti di universo dominate da materia e parti dominate da antimateria. Per esempio, dovremmo osservare i lampi emessi dall'occasionale annichilazione di materia ed antimateria. Inoltre, è improbabile che grandi porzioni di materia si siano separate abbastanza velocemente da analoghe porzioni di antimateria in seguito al Big Bang. Tutto sembra corroborare l'ipotesi che l'Universo attuale sia dominato da materia. Occorre sottolineare che, per generare l'attuale asimmetria, è sufficiente uno sbilancio incredibilmente piccolo. Sarebbe bastato che per ogni 30 milioni di antibarioni ci fossero stati 30 milioni ed 1 barione nel primo microsecondo dell'universo.

INCISO: I barioni sono una famiglia di particelle subatomiche che comprende i protoni, i neutroni (collettivamente chiamati nucleoni), e una serie di particelle pesanti e instabili (chiamate iperioni). Il termine "barione" deriva dal greco barys, che significa "pesante", in quanto sono più pesanti degli altri gruppi di particelle. I barioni sono fermioni ad interazione forte, ovvero, sono soggetti alla forza nucleare forte e sono descritti dalla statistica di Fermi-Dirac , che si applica a tutte le particelle che obbediscono al principio di esclusione di Pauli. Questo, in contrasto con i bosoni, che invece non rispettano il principio di esclusione. I barioni, assieme ai mesoni, appartengono alla famiglia delle particelle note come adroni, ovvero le particelle composte da quark. I barioni hanno tre quark, mentre i mesoni hanno un quark e un anti-quark e quindi sono bosoni. In aggiunta ai nucleoni (protoni e neutroni), altri membri della famiglia dei barioni sono le particelle lambda, sigma, delta, xi, e N.

I raggi cosmici e l'ANTIMATERIA

L'equazione del comportamento delle particelle cariche relativistiche, descritta da Dirac, presuppone l'esistenza di uno stato a energia negativa: ad esempio l'anti-elettrone (o positrone) è una particella avente le stesse caratteristiche dell'elettrone in massa, ma carica opposta. Attualmente si ritiene che il mondo e tutti i fenomeni che in esso avvengono siano composti a partire da alcuni mattoni fondamentali, i quark leggeri u, d e gli elettroni. Quantità minime delle rispettive antiparticelle, antiquark e antielettroni si trovano in particolari intervalli di tempo e in poche località terrestri, prodotte in laboratori, quali per esempio il CERN (Ginevra), il FermiLab (Chicago), SLAC (Stanford), LNF (Frascati) e a Novosibirsk (Russia). I raggi cosmici della Galassia contengono una frazione di antiprotoni e positroni, rispettivamente in quantità circa un decimillesimo ed un decimo rispetto alle corrispondenti particelle. Questa quantità ragguardevole di antimateria è, entro le incertezze dei dati sperimentali, compatibile con la produzione di antimateria negli urti dei protoni primari dei raggi cosmici con gli atomi di idrogeno negli spazi interstellari della Via Lattea. Lo studio degli antiprotoni richiede esperimenti fuori dell'atmosfera e con strumentazione abbastanza sofisticata. I primi esperimenti significativi sono stati intrapresi con palloni stratosferici, seguendo i suggerimenti di Luis Alvarez. Ottimi risultati sugli antiprotoni sono stati ottenuti dalla collaborazione Wizard in particolare con la missione CAPRICE, nella quale l'INFN ha partecipato con un elevato numero di afferenti, e dalla collaborazione BESS, che ha invece coinvolto il Giappone e gli Stati Uniti. Se nella ricerca di antimateria cosmica si trovasse una traccia di antielio, superiore a 10-12 rispetto all'elio, non sarebbe possibile darne spiegazione utilizzando la produzione secondaria, il che ci porta inevitabilmente a concludere che in qualche parte dell'universo esisterebbe, allora, una componente macroscopica di antimateria. Gli esperimenti su pallone ed il volo ingegneristico della missione AMS sullo Shuttle nel 1998 hanno prodotto, finora, un limite sul rapporto tra elio e antielio pari a 10-6. La missione AMS, la cui installazione sulla Stazione spaziale internazionale è fissata per il 2004, sarà in grado di misurare il rapporto antielio/elio fino a un fattore dell'ordine di 10-9. Anche in questo caso l'INFN ha investito le sue risorse culturali e tecnologiche. Prima che AMS giunga in orbita, il gruppo Wizard ha lanciato nello spazio PAMELA, un satellite in grado di osservare l'antimateria protonica, elettronica e dell'elio in un intervallo di energia molto ampio, con l'intento di osservare la componente più energetica dell'antielio, l'unica in grado di pervenire da eventuali anti-galassie lontane.

INCISO: Raggi cosmici dal Sistema solare. I raggi cosmici anomali sono costituiti da particelle che il vento solare riesce a accelerare a altissima velocità. Recentemente, un team di astronomi del Southwest Research Institute di San Antonio, in Texas, ha scoperto che una fetta di questi raggi proviene dai corpi celesti vaganti nella Fascia di Kuiper.

Con questa scoperta, si è potuto osservare come la polvere cosmica mantiene un ruolo preponderante nel generare particelle energetiche. Inoltre, sono le collisioni fra gli oggetti della Fascia di Kuiper a produrre i grani di polvere. Quando il moto di questi grani si orienta verso il Sole, essi ricevono un bombardamento da parte delle particelle che compongono il vento solare e vengono ionizzati dalle radiazioni. La ricerca è stata divulgata dalla rivista "Geophysical Research Letters".

NOTA: La Fascia di Kuiper è una regione del Sistema Solare che si estende dall'orbita di Nettuno (alla distanza di 30 UA) fino a 50 UA dal Sole. Si tratta di una fascia di asteroidi esterna rispetto all'orbita dei pianeti maggiori. Nella fascia sono stati scoperti più di 800 oggetti (Kuiper belt objects, o KBOs). Il più grande è in realtà il pianeta "ordinario" Plutone, assieme al suo satellite Caronte, ma a partire dall'anno 2000 sono stati trovati altri oggetti di dimensioni ragguardevoli: Quaoar, scoperto nel 2002, è grande la metà di Plutone, e quindi è più grande del maggiore degli asteroidi tradizionali, 1 Ceres. Gli altri KBOs sono progressivamente più piccoli. L'esatta classificazione di questi oggetti non è chiara, perché sono probabilmente molto differenti dagli asteroidi più interni. La maggior parte dei KBOs, come si è visto usando la spettroscopia, sono pezzi di ghiaccio con del materiale organico (contenente carbonio). Hanno la stessa composizione delle comete, e molti astronomi pensano che siano appunto comete che, non avvicinandosi mai al Sole, non emettono la loro coda. La distinzione tra cometa e asteroide non è molto chiara e le incertezze abbondano, come mostrato dal caso dell'asteroide 2060 Chirone. Simulazioni al computer hanno mostrato che la fascia di Kuiper si è formata sia a causa di Giove (all'inizio della storia del Sistema Solare, la considerevole gravità del pianeta ha fatto sì che molti piccoli oggetti fossero espulsi dalle regioni interne del sistema, ma non completamente), sia spontaneamente. Le stesse simulazioni e altre teorie predicono che nella fascia dovrebbero trovarsi anche oggetti di massa considerevole, paragonabili a Marte o alla Terra. Alcuni KBOs hanno orbite eccentriche e intersecano quella di Nettuno. Questi oggetti si trovano in risonanza orbitale, in vari rapporti: 1:2, 2:3 (questo è il caso di Plutone, e di oggetti simili chiamati plutini), 2:5, 3:4, 3:5, 4:5, 4:7. Questa fascia non deve essere confusa con la nube di Oort, che non si trova solo sul piano generale del Sistema Solare, ed è molto più distante. I primi astronomi a suggerire l'esistenza di questa fascia furono Frederick C. Leonard nel 1930 e Kenneth E. Edgeworth nel 1943. Nel 1951, Gerard Kuiper suggerì che gli oggetti non si trovavano più nella fascia. Congetture più dettagliate furono esposte da Al G. W. Cameron nel 1962, Fred L. Whipple nel 1964, e Julio Fernandez nel 1980. La fascia e gli oggetti in essa contenuti furono chiamati col nome di Kuiper dopo la scoperta di 1992 QB1, il primo oggetto conosciuto. È difficile stimare il diametro dei KBOs. Per oggetti di cui si conoscono molto bene gli elementi orbitali (in pratica, solo Plutone e Caronte), i diametri possono essere misurati con precisione dall'occultazione delle stelle. Per altri KBOs di grandi dimensioni, il diametro può essere stimato da misure termiche nell'infrarosse. Se un corpo ha un alto albedo, finisce con l'essere freddo, e quindi non produce molta radiazione nell'infrarosso. Al contrario, un albedo basso produce più radiazione infrarossa. I KBOs sono così lontani dal sole da essere molto freddi, e producono una radiazione con una lunghezza d'onda attorno ai 60 micrometri. Questa radiazione è assorbita dall'atmosfera terrestre, e quindi non può essere osservata: gli astronomi devono quindi osservare la radiazione residua nel lontano infrarosso, e il diametro stimato è affetto da una grossa incertezza. Inoltre, la radiazione emessa è molto debole e solo i più grandi KBOs possono essere osservati con questo metodo.

Cenni storici... (alla scoperta dei Raggi Cosmici)

L'invisibile pioggia di particelle che arriva a terra in ogni istante è un messaggio che l'universo regala A noi scienziati per parlare di sé. Raggi cosmici, questo è il loro nome, ed evoca la loro provenienza, ma non la loro origine, ricorda i raggi del Sole, ma non si tratta solo di fotoni. Quando furono scoperti era il 1912. Allora l’unica particella nota era l'elettrone, Niels Bohr non aveva ancora presentato la sua teoria atomica e la descrizione quantistica del microcosmo era ancora lontana. In quel periodo si indagava sull’origine dei fenomeni radioattivi, che risultavano onnipresenti ed ineliminabili anche con schermature. L'austriaco Victor Hess iniziò una serie sistematica di esperimenti salendo in quota con dei palloni, per individuare la sorgente della radioattività. Misure dettagliate permisero ad Hess di dichiarare con certezza: "I risultati delle presenti osservazioni possono essere spiegati ammettendo la presenza di una radiazione estremamente energetica che penetra l'atmosfera e, interagendo, provoca la ionizzazione dell'aria così come essa viene osservata". Per Hess si trattava di raggi gamma, gli stessi osservati nel decadimento radioattivo naturale; della stessa idea era Robert Millikan, che nel 1925 li chiamò, appunto, cosmic radiation o cosmic rays. Questa analogia accompagnò da subito gli scienziati, che, in quegli anni, stavano cercando di comprendere la natura dell'atomo. Si era ancora lontani dalla costruzione di grandi acceleratori, esistevano allora solamente pionieristici rivelatori costituiti da camere a nebbia, dove le particelle lasciavano la loro traccia a goccioline, passando attraverso un gas in sovrapressione, e contatori Geiger, in cui le particelle producono una scarica elettrica. Impilando contatori Geiger a formare “telescopi”, Walther Bothe e Werner Kolhörster nel 1928 provarono la natura corpuscolare dei raggi cosmici; il loro risultato venne confermato ed approfondito a Firenze da Bruno Rossi, che sviluppò dei circuiti elettronici per studi sistematici dei raggi cosmici. Fino agli anni ‘50, i raggi cosmici rimasero la sola sorgente naturale di particelle di alta energia, in grado di produrre nuove specie materiali. Permisero così la prima osservazione sperimentale di due fondamentali scoperte nel campo della fisica delle particelle: l'antimateria e il processo di decadimento del pione. Nel 1932 Carl Anderson osservò delle particelle cariche positivamente, che lasciavano nella camera a nebbia la stessa traccia degli elettroni. I suoi risultati furono convalidati nel 1933 da Patrick Blackett e Giuseppe Occhialini che riconobbero in esse l’antielettrone o positrone proposto teoricamente da Paul Dirac, osservando la conversione di fotoni di alta energia in coppie elettrone-positrone. Particella predetta nel 1936 da Hideki Yukawa, il pione si osservò sperimentalmente solo nel 1947 da parte di Cecil Frank Pawel, Occhialini e Cesar Lattes, utilizzando speciali emulsioni fotografiche per registrare la produzione di pioni da parte dei raggi cosmici e il loro successivo decadimento in muoni, che a loro volta decadono in elettroni (o positroni) e in neutrini. L'osservazione di sciami di particelle prodotte nelle camere a nebbia suggerì che gli stessi raggi cosmici, così come arrivavano a terra, dovevano essere il prodotto di interazioni e decadimenti successivi generati nell'interazione con l'atmosfera. La distinzione tra raggi cosmici primari e secondari, terziari e di livelli successivi emerse rapidamente. Si pose inevitabilmente la questione sull'origine e la provenienza dei raggi primari. Le ipotesi che vennero avvalorate proposero come possibile sorgente e sede dell'accelerazione dei raggi cosmici inizialmente il Sole (Teller), poi la galassia (Fermi) e infine Cocconi nel 1956 notò che la componente più energetica aveva caratteristiche extragalattiche. Era necessario aspettare l'inizio della conquista dello spazio per comprendere più a fondo la provenienza dei raggi cosmici. Quarant'anni di missioni spaziali non sono molti, ma hanno suggerito agli scienziati di cercare e verificare nell'universo proprietà fondamentali nello studio di oggetti celesti, come buchi neri, stelle di neutroni e sorgenti extragalattiche lontane nello spazio e nel tempo. Ai raggi cosmici l'onore di essere i messaggeri di quell'informazione che la tecnologia non potrà mai realizzare, una macchina del tempo, efficiente e poco dispendiosa, a disposizione di noi scienziati e di tutti gli interessati a leggere il libro dell'universo, delle sue leggi e della sua storia.

I raggi cosmici e gli sciami atmosferici

Le prime evidenze di una componente molto energetica dei raggi cosmici e la scoperta degli sciami atmosferici portano la data del 1930 quando il gruppo di scienziati guidato da Pierre Auger osservò coincidenze tra contatori di particelle separati tra loro sino a distanze di 300 metri. Queste coincidenze furono propriamente interpretate come il risultato di sciami estesi generati nell'atmosfera dai raggi cosmici primari nel loro viaggio verso la superficie terrestre. Nel 1949 lo studio degli sciami estesi era diventata una tecnica capace di quantificare l'energia dei raggi primari con circa il 30 per cento di precisione. Nello stesso anno, Enrico Fermi da Chicago propose l'esclusione degli elettroni come primari in una lettera di risposta a Giuseppe Cocconi, che al tempo si trovava alla Cornell University di New York, suggerendo inoltre di abbandonare le ipotesi di Edward Teller sull'origine locale dei raggi cosmici, per seguire la strada dell'origine galattica. Teller giustificava la sua posizione con considerazioni di natura energetica. Calcolando, infatti, dal flusso di raggi cosmici la densità di energia misurata nelle vicinanze della terra e moltiplicata per il volume della Via Lattea si trova un valore totale di energia talmente alto, giustificabile solamente presupponendo la localizzazione dei raggi cosmici nel sistema Solare. Passarono pochi anni e nel 1956 Cocconi presentò l'ipotesi avvalorata sperimentalmente che i raggi cosmici, di energia superiore ai 1018 eV possono essere accelerati negli spazi intergalattici, divenendo così i principali messaggeri dell'informazione a distanze extragalattiche. La strada però era ancora in salita. Infatti, l'osservazione sperimentale dei raggi cosmici di energia superiore ai 1020 eV è estremamente complessa perché la loro frequenza di arrivo al suolo è molto bassa (dell'ordine di uno al km2 al secolo). Due sono attualmente le strategie che gli scienziati stanno percorrendo: da una parte costruire strumenti con ampie superfici di raccolta per i raggi cosmici, dall'altra mandare i rivelatori nello spazio. In entrambi i casi l'INFN si è e si sta impegnando a dare il suo sostegno intellettuale, scientifico e finanziario, partecipando alla realizzazione del progetto AUGER così chiamato in onore del fisico francese e di EUSO (Extreme Universe Space Observatory) un rivelatore per raggi cosmici di altissima energia ospitato sulla Stazione Spaziale Internazionale. AUGER (vedi anche[PDF-file]: L'osservatorio per raggi cosmici AUGER e anche il link(s): AUGER.ORG CERN-courier) sarà il più grande osservatorio del mondo. Con i suoi 3000 km2 (quasi dieci volte Parigi) e 1600 rivelatori, ha consentito, dal 2001, di determinare con estrema accuratezza la direzione, l'energia e la massa dei raggi cosmici, parametri necessari per comprendere meglio i meccanismi di accelerazione più potenti nell'universo, per studiare le isotropie e dare spiegazioni alle strutture di larga scala, per far svelare i segreti passati del cosmo ai neutrini. A partire dal 2007 EUSO, invece, punterà lo sguardo agli estremi confini del mondo fisico, ai primi istanti dell'universo. Osservando la fluorescenza, prodotta nell'atmosfera da sciami generati da raggi cosmici e da neutrini di energie estreme e focalizzata con una grande lente ottica di Fresnel sul piano del rivelatore, consentirà di ricostruire la direzione di arrivo dello sciame e la sua energia con estrema precisione.

Sorgenti puntiformi di raggi cosmici

Le particelle di origine cosmica che osserviamo da terra sono principalmente i prodotti delle interazioni dei raggi cosmici primari con l'atmosfera. Lo studio della componente primaria ha richiesto di porre delicate strumentazioni su palloni atmosferici e su satelliti. Grazie a queste misurazioni, dopo quasi un secolo dalle misure di Hess, si conoscono molti dettagli delle proprietà dei raggi cosmici quali la loro distribuzione spettrale e la loro composizione. La componente principale dei raggi cosmici primari sono i protoni e gli atomi di elio. La percentuale degli altri elementi è pressoché analoga a quella presente nel sistema solare, tranne che per il litio, il berillio e il boro, eccessi probabilmente prodotti dalle interazioni dei protoni con il materiale presente nello spazio interstellare. Lo studio di queste abbondanze e l'analisi delle vite medie di alcuni di essi hanno suggerito che la gran parte dei raggi cosmici sia concentrata all'interno nella Galassia. Ulteriore conseguenza delle loro interazioni con la materia interstellare è la produzione di una intensa radiazione gamma, derivante dal decadimento del pione neutro. Se si osserva, quindi, la Galassia in queste lunghezze d'onda (da 100 MeV in su), la componente dominante è proprio il bagliore concentrato attorno al piano galattico, in cui le interazioni dei raggi cosmici e i processi che coinvolgono gli elettroni presenti nella radiazione cosmica fanno la parte del leone. Essi interagiscono con i campi elettromagnetici e con la materia dello spazio interstellare e con la stessa radiazione prodotta dalle stelle dando origine alla radiazione gamma. La possibilità di osservare tali lunghezze d'onda, invisibili da terra, ha permesso di studiare la percentuale di raggi cosmici e la stessa struttura della Via Lattea. È grazie allo sviluppo delle tecnologie spaziali, a partire dalla fine degli anni sessanta, che questa componente dello spettro elettromagnetico è divenuta accessibile. Dopo la missione statunitense SAS-2 (1972-73), che scoprì l'emissione diffusa proveniente dalla Galassia e originata da alcuni resti di supernova, furono soprattutto i satelliti COS-B, europeo, e EGRET, a bordo del Compton Gamma Ray Observatory (CGRO) statunitense, a dare un impulso decisivo a questa scienza. COS-B (1975-82), infatti, rivelò l'emissione gamma dalle pulsar - stelle di neutroni rotanti - ed individuò la prima sorgente gamma extragalattica. EGRET (1991-2000), invece, permise di delineare molto più in dettaglio l'emissione diffusa e localizzò circa trecento sorgenti puntiformi, tra cui i Gamma-Ray Bursts, misteriosi oggetti posti ai confini dell'universo; osservò inoltre l'emissione gamma prodotta dalle interazioni dei raggi cosmici presenti nelle Nubi di Magellano, galassie satelliti della Via Lattea, confermando così l'ipotesi di una origine degli stessi all'interno delle galassie. Se sono noti i meccanismi con cui i raggi cosmici interagiscono con la materia interstellare, poco noto ancora è il processo che permette di accelerarli fino alle energie con cui vengono osservati. È questo uno dei principali obiettivi scientifici delle future missioni spaziali dedicate all'astronomia gamma, in cui l'INFN sta svolgendo un ruolo decisivo. AGILE (Astrorivelatore Gamma a Immagini LEggero) e GLAST (Gamma ray Large Area Space Telescope) che volerà nel 2007, utilizzeranno la tecnologia dei rivelatori a semiconduttore. Questa tecnologia permetterà di individuare con molta più precisione la direzione di arrivo dei raggi gamma. In questo modo si potrà distinguere nel dettaglio l'emissione gamma prodotta nei resti di supernova. Si ritiene, infatti, che siano le onde d'urto prodotte da tali esplosioni a fornire l'energia ai raggi cosmici. Analoghi meccanismi sono all'opera nelle sorgenti gamma più intense, come i nuclei galattici attivi o i Gamma-Ray Bursts. Si ipotizza che siano essi ad accelerare i raggi cosmici fino alle altissime energie, e un lodevole contributo alla comprensione di questo fenomeno celeste è stato dato dalla missione spaziale per raggi X, Beppo SAX. Le future missioni per l'astronomia gamma permetteranno, allora, di esplorare sorgenti fino ai confini dell'universo, nonché di cercare di rispondere a interrogativi decisivi per la comprensione della struttura e dell'unità del cosmo, quali l'identificazione della materia oscura o la natura quantistica dello spazio tempo.

NOTA-(1): Sulla natura quantistica dello spazio tempo (alcune mie riflessioni...).