Capitolo I: I vettori del sistema

Capitolo I: I vettori del sistema

L’uomo ha sempre avuto come suo istinto naturale la comunicazione. La comunicazione viene definita come un trasferimento di informazioni codificate da un emittente verso un ricevente attraverso un canale. Questo è il modello[1] più semplicistico di ciò che chiamiamo comunicazione. Numerosi sono gli studi che riguardano questo campo della teoria dell’informazione, ma non è questo il target del mio studio. Qui mi appresto solo a puntualizzare le basi teoriche che vi soggiacciono.

La comunicazione è, tuttavia, un evento estremamente improbabile[2]. Essa si realizza tramite strumenti denominati media, mezzi di diffusione che rendono meno improbabile il concatenamento comunicativo.

I media hanno attraversato la storia delle culture umane evolvendosi di pari passo:

Segni e segnali erano usati dagli esseri pre-umani che comunicavano seguendo l’istinto e i fattori ereditari. Solo l’acquisizione della capacità di apprendimento ha consentito alle prime comunità di dotarsi di un sistema standardizzato di segni.

Tra i 40.000 e i 35.000 anni fa la capacità di immagazzinare e di trasmettere ai successori le tecniche di sopravvivenza da avvio all’età della parola. L’evoluzione del linguaggio permise all’uomo di ricordare, trasmettere, ricevere, comprendere e quindi affrontare l’ambiente fisico e sociale.

Pitture,

immagini pittografiche e geroglifici rappresentano i primi tentavi di

scrittura. Solo con i Sumeri nel

Con l’invenzione della stampa nel XV secolo[4] diventò facile stampare i libri che si diffusero sempre più ampiamente nelle case[5]. La stampa comporta anche la proliferazione delle “Gazzette” e pubblicazioni di carattere informativo dedicate soprattutto ai mercanti. Tra il ‘600 e il ‘700 comincia a svilupparsi un mercato delle informazioni, tanto che la nuova società post-rivoluzione industriale scopre che l’informazione a mezzo stampa[6] è uno strumento indispensabile per il suo funzionamento.

La nuova era si aprì con il telegrafo senza fili. Nel 1884 Samuel Morse presentò la sua scoperta che consentiva la trasmissione a distanza dei messaggi utilizzando come canale l’etere.

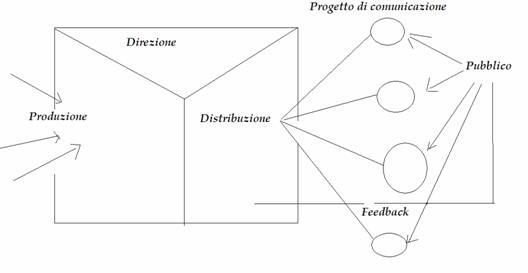

La comunicazione di massa è un processo che dipende da un’azione complessa dei mezzi di comunicazione. I messaggi, elaborati da una organizzazione che si inserisce all’interno del processo comunicativo, vengono trasmessi da mezzi tecnici a masse molto grandi che vivono in aeree geografiche ampie, a volte anche lontane dalle fonti di emissione. Il messaggio è costituito da un determinato numero di prodotti uguali (es. giornali) diffusi in maniera simultanea ad un pubblico che fornisce il parametro audience.

Figura 1: La comunicazione di massa

Le grandi innovazioni tecnologiche hanno completamente trasformato il mondo della comunicazione–informazione, e la vita stessa dell’uomo: fotografia, telefono, cinema, e ancora più la radio[7] e la televisione[8].

Luhmann parlando del rapporto tra società e media ha scritto:

Fino alla stampa del libro, si era partiti ancora da un primato della comunicazione orale e si era vista la scrittura essenzialmente come mezzo con il quale annotare e tener fermi contenuti che ancora dovevano essere comunicati o, quanto meno, non si era operata una distinzione chiara tra medium della annotazione e medium della comunicazione. Comunicatio significava: produrre comunanza, rendere noto […] nel nostro secolo si perviene ad una rinnovata esplosione delle comunicazione […] la telecomunicazione rende possibile la comunicazione di immagini in movimento. La riproduzione ottica e acustica, che con la scrittura erano state separate in modo così netto, si fondono assieme. In sostanza, questa scoperta porta al fatto che tutto è comunicabile […] i nuovi media di questo secolo hanno allargato ancora una volta le universali possibilità della comunicazione. Essi rendono così più acuta la discrepanza tra comunicazione possibile e comunicazione che attualmente ha luogo.

Nell’evoluzione dei media della diffusione c’è una tendenza continua a passare da un ordine gerarchico ad uno eterarchico.

Mentre nella costruzione della differenziazione sociale, nella fondazione degli imperi, nel predominio delle città, la stratificazione sociale poggia su un ordine gerarchico, i media della diffusione lavorano parallelamente alla delegittimazione di quell’ordine, o più precisamente lavorano ad un progetto alternativo. Nelle gerarchie è sufficiente influenzare il vertice perché si può partire con il presupposto che il vertice si imporrà. Al contrario le eterarchie poggiano su contatti immediati, che discriminano di volta in volta. In Cina e Corea, la stampa serve come strumento della diffusione nelle mani della gerarchia burocratica. In Europa la censura non si può risolvere che in un insuccesso data la molteplicità dei luoghi dove si stampa e data anche la complessità dei contenuti, costringendo tutte le gerarchie ad abituarsi a convivere con una società che comunica in modo essenzialmente eterarchico. Dal XVIII secolo si celebra questa situazione come superiorità dell’opinione pubblica.[9]

Il concetto di opinione pubblica ci introduce al grande ruolo della comunicazione. Per parafrasare Walter Lippmann[10] “il nostro mondo è troppo grande, troppo fuggevole e troppo complesso per averne una conoscenza diretta […] dobbiamo affidarci ad un modello più semplice”.

Quanto noi sappiamo dell’ambiente e del mondo in cui crediamo di vivere è composto solo in piccola parte da ciò che abbiamo visto o sentito personalmente e, per la quasi totalità, da ciò che conosciamo in maniera mediata, ovvero attraverso il racconto degli altri.

La comunicazione oggi è il principale strumento di consenso sociale e tutti, ad ogni livello, tentano di addomesticarla. Benché si voglia rivendicare l’autonomia del sistema di comunicazione di massa, in realtà esso è legato profondamente con altri sistemi con cui interagisce continuamente, sia esso economico, politico o culturale. Infatti i media sono una fonte di guadagno molto appetibile che ha un legame a doppio taglio con il sistema politico di cui vogliono essere dogwatcher, ma da cui spesso sono controllati. Non meno importante il rapporto con il sistema culturale, con la caratteristica, propria dei media di massa, di creare valori condivisi e trasmettere simboli e stili di vita dominanti.

Inoltre i media hanno una fortissima influenza sulle opinioni di “come va il mondo” espresse dall’opinione pubblica; con la prassi dell’agenda setting si va ad identificare quel fenomeno che vuole collocare nei media la capacità di stabilire a priori su cosa concentrare l’attenzione del pubblico. L’influenza dei media giudicata dai primi studi come “molto alta” è stata ridimensionata dalle ricerche degli anni ’80. Oggi non c’è per gli studiosi una vera e propria persuasione, ma i media determinerebbero la nostra agenda mentale, cioè gli argomenti di cui è necessario occuparsi, attraverso la selezione delle notizie tra gli argomenti notiziabili e la loro gerarchizzazione.

Questa caratteristica rende il sistema molto aperto alla manipolazione, specie ad opera del sistema politico dominante nel paese. Da qui il dibattito sempre molto acceso nelle democrazie sulla necessità del pluralismo informativo. L’esigenza utopica di avere tutte le informazioni rappresenta il grado massimo di una ipotetica retta che unisce il grado informativo zero ad una informazione esaustiva e precisa. La complessità, che si traduce in problema di gestione delle informazioni, è nemica della democrazia. Come ricorda Granieri[11] “l’efficacia di una democrazia è sempre proporzionale alla sua capacità di gestire informazioni”. Come quando nell’agorà ateniese del V secolo a.C. la scrittura venne a sostegno della comunità, costituendo il supporto per rendere condivise le leggi, oggi si può, ad un tempo, svecchiare il modello di democrazia rappresentativa[12] e, contemporaneamente, combattere l’information overload. Rispolverare quello spirito ateniese di partecipazione popolare è ora possibile, grazie ai nuovi strumenti che piano piano stanno nascendo e prendendo piede.

“I media sono apparati culturali che usano tecnologie

per selezionare, raccogliere, immagazzinare, inviare conoscenza, in forme

rappresentative[13] ”

“In una società dove l’informazione e la comunicazione

sono onnipresenti, la posta in gioco non è la gestione degli individui o delle

collettività, ma la gestione delle loro differenze: non la gestione delle loro

somiglianze, ma quella molto più complessa delle loro alterità[14]

“

Fino a qui ho definito i media come artefatti tecnologici che possono essere usati dai vari attori sociali per mettere in atto strategie comunicative, al fine di perseguire una serie di scopi.

I media veicolano visioni del mondo, rappresentazioni sociali della realtà di cui sono portatori. Quotidianamente li utilizziamo nei nostri processi cognitivi per orientarci e inquadrare situazioni inedite. L’importanza sociale sta nella natura educatrice dei media. Essi educano l’opinione pubblica e formano le coscienze nella misura in cui il consumo mediale influenza, stimola, interagisce con la personalità dell’individuo e il suo senso critico, le variabili ambientali e l’azione più o meno incisiva delle altre agenzie di socializzazione.

Tuttavia sarebbe sbagliato considerare i media come entità unidirezionali. Soprattutto nel medium Internet, ma anche, in maniera meno evidente, negli altri media, esiste un effetto retroattivo dell’utente sul sistema, definito feedback. Gli utenti hanno, infatti, un ruolo attivo nella fruizione e nella co-costruzione dell’universo simbolico che soggiace ad ogni sistema sociale. Essi esercitano una retroazione che rielabora e rinnova i contenuti veicolati dai media.

Ora è bene introdurre alcuni concetti base:

Ipertesto_ strumento reale o virtuale concepito per

rendere agevoli le associazioni e i legami tra elementi testuali. Nel 1965

Theodor Nelson conia il termine ipertext

riferendosi a “forme non sequenziali di

scrittura congiunte tramite collegamenti”. Un precursore dell’ipertesto

è Vannevar Bush, dal 1941 direttore dell’Ufficio per

Ipermedia_ sistema che applica metodi e tecniche ipertestuali alla gestione di informazioni di natura multimediale.

Multimedia_ ambiente in cui coesistono più codici di comunicazione in grado di contenere e elaborare differenti sorgenti di informazione e comunicazione.

Queste premesse mi permettono di potere ora parlare di Internet. Sono passati 11 anni da quando questo nuovo media è entrato nell’immaginario collettivo. Nel 2005 Mark Pesce, uno dei più stimati guru del web, ha iniziato il suo intervento all’Australian Film Television and Radio School con queste parole: “Il 18 ottobre 2004 è il giorno in cui è morta la televisione”. La sua non era una frase ad effetto[15]. Oggi chiunque può creare una Tv a costo zero[16]. Il Web ha cambiato il modo di fruire i contenuti, siano essi testi, audio o video; una sorta di jukebox aperto ai contributi di tutti, consultabile in qualunque momento, da chiunque, con qualunque strumento[17].

Il tutto inizia con la creazione di ARPANET nel 1969. Subito dopo la fine del secondo conflitto mondiale fu creata negli Stati Uniti una nuova agenzia, l’ARPA (Advanced Reserch Project Agency), che nel 1958 assunse il controllo di tutte le ricerche scientifiche a lungo termine in campo militare. Dieci anni dopo i materiali delle ricerche si trovavano in vari computer sparsi in diversi sedi sul territorio americano. Si cercò quindi un modo per collegare le varie sedi: ARPANET venne pianificata e realizzata dall’IPTO, un dipartimento che coinvolgeva molteplici centri di ricerca. ARPANET sarebbe servita per creare un network invulnerabile ad un attacco nucleare. Il primo collegamento telefonico ARPANET da computer a computer fu effettuato nell’ottobre 1969 fra l’Università della California e lo Stanford Research Istitute. Alla fine del 1972 il network contava 32 nodi. L’anno dopo viene formalizzato il protocollo di controllo trasmissione (TCP), a cui si aggiunse nel ’78 il protocollo tra rete e rete (IP) per dar origine al definitivo protocollo TCP/IP su cui ancora opera Internet. Nel 1983 il Dipartimento della Difesa crea una sua rete protetta MILNET, mentre nel 1990 ARPANET, divenuta obsoleta, viene smantellata a favore di una nuove rete creata nell’83, ARPA-INTERNET[18], che, negli anni ‘90, viene via via privatizzata con la creazione di service provider.

Un altro apporto importante viene dalla comunità di utenti UNIX, un sistema operativo sviluppato dai Bell Laboratories e rilasciato alle università nel 1974 con il codice sorgente e il permesso di implementarlo. Unix ha dato vita al movimento open source, movimento che ha tentato di tenere aperto l’accesso a tutte le informazioni relative al software, e sfociato poi nell’introduzione del concetto di copyleft[19], opposto al copyright.

L’altra origine di Internet si trova nel BBS, Bolletin Board System, sistema che consentiva al pc di trasmettere e archiviare messaggi. Il programma fu creato da due studenti[20] dell’università di Chicago, essi stessi ideatori di un programma, battezzato MODEM che permetteva il trasferimento di file tra i loro pc, distribuito in forma open surce.

Tuttavia, Internet nasce per la massa, per le

imprese e per il mondo nel suo complesso, nel 1995, anno in cui Microsoft fa uscire Internet Explorer insieme con il proprio sistema operativo Windows 95. Nel frattempo il CERN[21] di

Ginevra aveva sviluppato un sistema per la condivisione di informazioni in

ipertesto, denominato World Wide Web,

il protocollo HTTP e le prima

versione del linguaggio HTML. Era il

1990. Nel 1994

Non si può considerare Internet come una semplice “rete delle reti”, né un agglomerato di siti web isolati, ma come il grado più alto raggiunto dall’uomo in materia di diffusione dell’informazione e condivisione del sapere.

Il termine Web 2.0 è l’espressione del dibattito attualmente in corso in merito alle nuove possibilità di fruizione offerte dalla Rete.

Originariamente il web era stato concepito come modo per visualizzare documenti ipertestuali statici creati con l’uso del linguaggio HTLM. Questo approccio può essere definito come Web 1.0.

Con l’utilizzo di database e sistemi di gestione dei contenuti (CMS), Internet si è evoluta con siti dinamici, ad esempio forum e blog.

Oggi, linguaggi di programmazione come Javascript, elementi dinamici e fogli di stile, permettono di creare vere e proprie “applicazioni web”. Con il nome di Web 2.0 si tenta di dare un nome ad un insieme non omogeneo di innovazioni emergenti, nuove tipologie di società e servizi in grado di offrire applicazioni web agli utenti finali.

Da un punto di vista tecnologico il Web 2.0 è del tutto equivalente al Web tradizionale[22]. La differenza sta nell’approccio con cui gli utenti si rivolgono al Web. Dal consumo si sta passando alla partecipazione, dalla fruizione passiva di contenuti altrui, all’esplosione dei contenuti generati dagli utenti, distribuiti e ri-usati in mille modi diversi.

La possibilità di creare e condividere contenuti sul Web è data da una serie di strumenti, tool, on-line che permettono di utilizzare il web come se si trattasse di una normale applicazione desktop[23], coniugata alla pubblicazione immediata del contenuto, la sua classificazione ed indicizzazione nei motori di ricerca, in modo che l’informazione sia subito disponibile a beneficio della comunità.

Figura 2: The Web

2.0 is made of people

Una nuova filosofia all’insegna della collaborazione, che trasforma ogni utente da consumatore a partecipante.

La maggioranza dei contenuti Internet sono generati attualmente dagli utenti, infatti il Web 2.0 descrive l’inversione del controllo dell’informazione, dei processi e dei software. Tutti abbiamo ora il nostro pulpito personale sul mondo, sia esso nella forma dei blog, wiki, o altri meccanismi.

Figura

3: La

partecipazione on-line

Chi come programmatori, tecnici e business man ha già preso in seria considerazione le implicazioni del Web 2.0, ha pensato strategicamente anche gli aspetti sociali e i modelli di business che stanno emergendo. La trasformazione degli utenti da consumatori passivi a protagonisti attivi è quello che in gergo si definisce personal media revolution e che ha in J.D. Lasica[24] e Dan Gillmor[25] due delle principali icone. In altri termini tutti hanno la possibilità di diventare un media, a costi e con strumenti accessibili. La democratizzazione della creazione dei contenuti widepsread[26], ovvero la sistematizzazione del passaparola, è veramente ad un passo, mentre l’importanza del contenuto on-line ha sempre una maggiore influenza sul mondo off-line[27].

In questo contesto di napsterizzazione dei contenuti si devono reinventare nuovi modelli di business: trasformare cioè l’iperdistribuzione di contenuti, che avviene spesso in violazione del copyright, in un modello sostenibile.

Chriss Anderson[28] ha scritto nell’ottobre 2004 un articolo dal titolo:

La lunga coda.

Dimenticate di spremere

milioni da poche hit in cima alle classifiche. Il futuro dell’intrattenimento è

nei milioni di mercati di nicchia che si trovano ora nella bassofondo della

grande distribuzione[29].

Anderson fa notare che con Internet non esistono più alcuni limiti storici dei mercati tradizionali: spazio e soglia di distribuibilità. Si possono cioè ospitare un numero illimitato di pezzi e offrire prodotti di nicchia che generano ritorni limitati, risolvendo al tempo stesso il problema della distribuzione, raggiungendo località geografiche e nicchie di utenza tradizionalmente irraggiungibili. Venendo a mancare questi limiti, i ritorni generati dall’insieme dei piccoli può arrivare ad essere equivalente o superiore ai ritorni generati dai grandi hits. Se la legge di Pareto dell’80/20 dice che solo il 20% dei prodotti distribuiti diventerà un successo, sul web la realtà è che il 99% dei prodotti di un negozio on-line vengono acquistati o noleggiati almeno una volta al mese. Esiste cioè una domanda per ognuno dei titoli in vendita. La logica delle grandi produzioni può essere superata: con il Web siamo entrati nell’era dell’abbondanza. L’esistenza di infinite nicchie di consumatori, caratterizzate da gusti e preferenze più disparate, fa si che l’insieme dei prodotti di nicchia finirà per produrre utili uguali o superiori a quelle dei prodotti di punta e risultare molto più qualitativi.

Il concetto di condivisione dei dati tra le diverse piattaforme tecnologiche, sia hardware che software, sfrutta le potenzialità offerte da nuovi linguaggi che si stanno sviluppando in questi anni.

API è l’acronimo di Application Programming Interface, indica cioè un insieme di procedure disponibili al programmatore, interfacce essenziali per i computer. Alcune compagnie conservano gelosamente le loro API, ad esempio SONY e Microsoft, perché ambedue intendono restringere il numero di persone che possono scrivere applicazioni per i rispettivi sistemi operativi (o giochi se prendiamo il caso della console PlayStation). Altre compagnie distribuiscono le API pubblicamente. Una API che non richiede il pagamento dei diritti per il suo accesso e utilizzo è detta “aperta”.

Il potere delle open API sta nel fornire l’accesso ad ampi database informativi proprietari, che possono essere utilizzati per creare nuovi mix e combinazioni che altrimenti non sarebbero possibili. Amazon, Google, Yahoo!, eBay, Skype e molte altre eSociety, permettono agli sviluppatori che affollano la rete, di inventare nuove applicazioni per migliore i dati e le informazioni preesistenti. In sostanza il web diventa una piattaforma di sviluppo.

Per le persone che lavorano

in azienda, il web è una piattaforma per gli affari. Per chi si occupa di

marketing, il web è una piattaforma per la comunicazione. Per i giornalisti il

web è una piattaforma per i nuovi media. Per i tecnici, il web è una

piattaforma di sviluppo software[30].

HouseMaps.com[31] è un’applicazione che fornisce un esempio lampante del potenziale dell’interazione tra due API distinte, per fornire un servizio di ricerca di annunci immobiliari sul territorio americano. Il servizio, ideato da Paul Rademacher, incrocia la potenza di Google Maps agli annunci immobiliari di Craiglist. Esso permette di mostrare ai potenziali acquirenti l’esatta posizione della proprietà, il dettaglio, con le foto e le informazioni collegate. Utile, e sicuramente interessante.

Ringfo permette di verificare il costo e i giudizi del pubblico su un libro o cd venduto su Amazon, semplicemente componendo un numero telefonico e digitando il codice ISBN. Il servizio sfrutta le informazioni residenti in Amazon e le ridistribuisce utilizzando una interfaccia di dati XML, che vengono convertiti in suoni per dar voce alla “signorina” virtuale che risponde al telefono. Complicato? Andiamo con ordine.

Le applicazioni software derivano nuove informazioni da informazioni già esistenti, riconoscendo l’argomento di un testo, o il tono di una affermazione. Devono cioè comprendere le informazioni sulle informazioni, ciò che viene chiamato metadati.

XML è un insieme di regole per formulare dei file in formato testo che permettano di strutturare dati. Esso rende facile la generazione, la lettura e il controllo di dati tramite un computer. L’eXstensible Markup Language fa uso di tag (parole racchiuse tra parentesi angolari) e attributi per delimitare pezzi di dati, ma a differenza dell’HTML[32], ne lascia l’interpretazione all’applicazione che li legge. Lo sviluppo del linguaggio è iniziato nel 1996 e XHTML è un formato riconosciuto dal W3C, consorzio che formalizza gli standard di scrittura per il web. Il Resource Description Framework (RDF) è un XML formato testo che supporta la descrizione di risorse e applicazioni metadata come liste musicali, album di foto e bibliografie. Come l’HTML ha integrato documenti, immagini, sistemi a menu per lanciare il primo web, RDF fornisce strumenti per avvicinarsi al Web Semantico.

Le pagine web non sono scritte per essere lette da un computer. Per cui, noi possiamo trovare il DVD più economico, o comprare un libro, ma se lo chiediamo di farlo autonomamente ad un computer, ciò è impossibile.

I computer necessitano di meccanismi per accordarsi sul significato dei termini in modo da comunicare. Il progetto del World Wide Web Consortium[33], ora sotto la direzione di Tim Berners-Lee, sta cercando di provvedere a creare degli standard di comunicazione bastati su RDF e XML, linguaggi metatestuali che permettono di aggiungere ad ogni informazione delle “etichette”, per avere a disposizione degli strumenti in grado di gestire la polisemia[34] e di distinguere, ad esempio, un titolo da un indirizzo web.

Elaborare ontologie è invece più difficile. Una ontologia è un documento che definisce le relazioni tra i termini e le proprietà degli oggetti stessi. Da qui l’ideazione del OWL, Ontology Web Language, che aggiunge un maggiore vocabolario a XML e RDF per descrivere le proprietà e classi di oggetti, come disgiunzione, uguaglianze, quantità, simmetrie. Ecco la scommessa del Web Semantico, cioè quello di creare un medium universale per lo scambio di informazioni/documenti, scritti con una semantica comprensibile e gestibile da parte dei computer connessi in rete.

Le tecnologie per veicolare i metadati esistono. Da anni si utilizzano i Feed RSS per distribuire i contenuti via web. Acronimo di RDF Site Summary, è un linguaggio basato su XML. Lanciato per la prima volta da Netscape per gestire i contenuti del portale personalizzabile My Nescape, permetteva di visualizzare headline e link relativi a notizie pubblicate su altri siti. Benché ne esistano vari formati, tutti presentano la stessa struttura di base che si compone di un elemento, <channel>, che contiene le informazioni sulla fonte dei contenuti, ed una serie di <item> ognuno dei quali corrisponde ad un singolo elemento di contenuto (es. l’articolo di un giornale) e ne presenta le informazioni (titolo, testo, autore …).

Parlare di RSS e Syndication è la stessa cosa. Infatti RSS, per alcune interpretazioni, è anche acronimo di Realy Simple Syndication, dove per Syndication si indica un modo di trasmettere contenuti “simile al lavoro di una agenzia di stampa. Produce notizie strutturate semplicemente in titolo, testo, autore, data e ora di pubblicazione[35]”.

I file, generati automaticamente dai siti web che presentano questa caratteristica di condivisione, vengono letti o da news aggregator, software da installare sul proprio pc e che si trovano in forma freeware in rete, o da applicazioni web on-line che funzionano da aggregatori (vedi l’ultima relase di Netscape). Ad esempio un feed reader può estrarre i titoli di tutti gli elementi item per visualizzare la lista degli articoli di un giornale on-line, mentre un aggregatore estrae i contenuti del feed e li converte in linguaggio HTML presentandoli sulla pagina del proprio browser.

Figura

4:

Fruizione di un Feed RSS con FeedReader.

Un altro aspetto importante è la disponibilità di applicazioni per la lettura di feed su dispositivi mobili (cellulari, palmari), quale ad esempio mReader, che consentono la fruizione di informazioni in qualsiasi luogo e momento.

Figura 5: Fruizione di un feed RSS su un cellulare Nokia 3650 con mReader

AJAX è un approccio di sviluppo web basato su JavaScript e sul linguaggio di programmazione XML, permettendo alle pagine di funzionare più come applicazioni desktop, che come pagine di contenuto statico. Gli utenti possono infatti interagire con le informazioni nelle singole pagine, come se stessero usando un’applicazione.

Le applicazioni web tradizionali consentono all’utente di compilare moduli, e quando questi vengono inviati, parte una richiesta al web server, che risponde bloccando o mostrando una nuova pagina. Le applicazioni AJAX inviano richieste per ottenere solo i dati che le sono necessari, mostrandoli poi usando Java nella visualizzazione browser. Come risultato si ottengono applicazioni più veloci, dato la riduzione di dati scambiati con il server, mentre anche il tempo di elaborazione si riduce poiché la maggior parte dei dati della richiesta erano già stati elaborati.

Figura

6:

Interazione tra server e utente con Ajax

Il grande vantaggio di usare AJAX nella progettazione di “applicazioni web” sta nella velocità con la quale essa risponde agli input dell’utente.

Termine coniato nel 2004 da Thomas VanderWal, la folksonomy[36] o anche tagging, è un concetto semplice: quando si carica un contenuto in Internet lo si associa ad una categoria, tag.

Possiamo pensare al tagging come ad una forma di

classificazione del sapere decentralizzata, priva di un coordinamento unitario

[…] sono gli utenti a decidere autonomamente come classificare i concetti e

dati presenti in Internet. “Taggare” dei

dati sta avendo risvolti pratici decisamente rilevanti. Anzitutto

permette ai motori di ricerca come Technorati, sia di fare ricerche per

categorie indicate dagli utenti stessi, sia di capire quali sono le categorie

(= gli argomenti) più discussi della Rete[37].

La folksonomy è un sistema di classificazione a basso costo, un’alternativa ai più tradizionali e formalizzati sistemi di indicizzazione dal vocabolario controllato che necessitano di una organizzazione per controllare la classificazione dei contenuti.

Sono gli utenti a decidere quali tag associare ai propri post, e sono sempre gli stessi utenti ad avvisare i motori di ricerca, rendendoli di fatto più rapidi rispetto a quelli tradizionali.

I vantaggi ci sono, benché qualche limite, quale la gestione dei sinonimi, la mancanza di una gerarchia delle categorie (es. Internet>Siti Utili>Università), ed una sorta di relativismo per cui, alcuni termini, possono essere interpretati in maniera differente in base alle differenti culture/lingue.

Da un lato una grande

partecipazione e il coinvolgimento degli utenti; dall’altro il potenziale

disordine nella gestione dei dati e i problemi organizzativi [ma] quanti

all’inizio credevano che un’enciclopedia fatta dagli utenti, gratis, senza

quasi controllo, sarebbe potuta esistere e sopravvivere? Pochi. Ma Wikipedia

oggi esiste e funziona[38].

Il filo conduttore è una nuova filosofia all’insegna della collaborazione: interazione sociale mediata tecnologicamente. Questo è il Web 2.0.

I social network, o reti sociali, consistono in gruppi di persone intenzionati a condividere pensieri e conoscenze. Si trovano on-line comunità di persone che condividono i link a siti che ritengono interessanti, oppure alle foto o video, poesie, racconti e diari di eventi, tutti contenuti multimediali che essi intendono distribuire. Questi gruppi rappresentano una preziosa fonte di informazione e al contempo divengono divulgatori specializzati di argomenti di nicchia.

Un wiki[39] è un sito web, o una collezione di documenti ipertestuali, che permette a ciascuno dei suoi utilizzatori di aggiungere e/o modificare contenuti preesistenti. La navigazione è assolutamente non lineare, giacché ogni “pagina wiki” contiene un gran numero di collegamenti alle altre pagine.

I wiki

rappresentano l’espressione più democratica per la diffusione delle conoscenze

attraverso la rete. La logica che muove e sviluppa i wiki è la partecipazione

degli utenti ad un obbiettivo comune, quale la realizzazione della più grande

enciclopedia mondiale,

Il podcasting

è un sistema che permette di scaricare in modo automatico risorse audio o

video, chiamate podcast, utilizzando

un programma gratuito chiamato aggregatore o feeder. Il termine podcast nacque quando l’uso dei feed RSS divenne

popolare per lo scambio delle registrazioni audio. Pare che il primo ad

utilizzare la parola podcasting[40] sia stato il

giornalista del The Guardian, Ben

Hammersley, il 12 febbraio

Per chiarire: il broadcast indica una trasmissione radio/tv tradizionale, ascoltabile in una determinata ora decisa dall’emittente. Lo streaming indica una risorsa audio/video fruibile on-line in qualsiasi momento tramite un collegamento Internet al sito dell’emittente. Il podcasting indica una file scaricato automaticamente dal sito dell’emittente, fruibile off-line ed in condizione di mobilità con l’utilizzo di un riproduttore.

La diffusione del podcasting attira molte curiosità, sia in campo musicale, che giornalistico. RadioRai offre le proprie trasmissioni come podcast, lo stesso Repubblica Radio e molte altre emittenti nazionali.

Discorso a parte vale per i video. Il boom di un

sito di video sharing come YouTube ha creato una vasta eco di studi

sul fenomeno. Ian Hardy, corrispondente tecnologico per

Sempre più persone stanno guardando questi tipi di video,

distogliendo i loro occhi dallo schermo televisivo e muovendoli verso lo

schermo del computer[42].

L’esplosione della distribuzione dei video ha messo in luce i limiti del Web, soprattutto nel campo del costo in termini di “capacità di banda”, ovvero la difficoltà di consentire il simultaneo scaricamento di contenuti da un ampio numero di utenti. La soluzione si è trovata nell’utilizzo di BitTorrent, un software che sfrutta la tecnica del PeerToPeer, distribuendo tra gli utenti il carico[43] del servizio, e di progetti come BlogTorrent e Prodigem che permetto di semplificare il processo di creazione e distribuzione dei file.

Il blog rappresenta il vero e proprio punto di incontro tra l’utente e la moltitudine della comunità Internet. Il blogger, ha a sua disposizione una pagina da riempire, ogni qualvolta lo ritiene opportuno, con un proprio intervento, post, sia esso testo, audio, video, o si tratti semplicemente di un rinvio al contenuto di un altro sito che il blogger segnala a beneficio di coloro che lo leggeranno. Incuriosire, attirare e fidelizzare l’attenzione della comunità Internet è tutt’altro che semplice e me ne occuperò più in dettaglio nei prossimi capitoli.