|

|

|

|

|

|

CHI SONO

L' intento di

questo sito è di esplorare una delle tematiche più scottanti della ricerca

scientifica che, sebbene per molti resterà solo materiale per fantascienza, è

una realtà, portatrice di innovazioni pratiche, ma anche di inquietanti

prospettive. E' la proposta di un viaggio in quella che è stata sicuramente la

ricerca più affascinante e “interdisciplinare” degli ultimi cinquant’anni per

scoprire che probabilmente la prima forma di vita intelligente che l’uomo

incontrerà non viene da marte, ma abita nel suo cellulare …

Il sito è una raccolta di approfondimenti personali che ho piacere di

condividere col “popolo” della rete allo scopo di poter essere un’utile risorsa

oltre che, naturalmente, svago. Tutto ciò che contiene quindi è stato scritto

con proprie tesi di laurea e testi sotto mano, cercando di evitare ipotesi

azzardate, fraintendimenti e/o teorie personali che stanno facendo scadere

l’attendibilità della maggior parte delle informazioni reperite su internet. Ma

nonostante tutto sto ancora imparando e potrei commettere qualche errore, oltre

alla coscienza di un lavoro sicuramente poco organico e incompleto. In alcuni

casi non mi sono però privata totalmente del privilegio di esprimere alcune mie

opinioni che, per quanto poco azzardate e in ogni caso frutto di anni di studi,

ho voluto contraddistinguere esplicitamente dal resto.

DISCLAIMER

Si sottolinea che non s’intende contravvenire a nessuna violazione su diritti

d’autore e simili. Tutto il materiale presente nel sito è di proprietà

dell’autore. Per ogni teoria trattata o citazione è sempre indicato il nome del

proprietario dei diritti intellettuali. Nel caso di sviste od ommissioni in

citazioni o simili si contatti il webmaster cha sarà pronto a correggere

immediatamente l’errore.

INTELLIGENZA ARTIFICIALE

Con il termine intelligenza artificiale (spesso abbreviato

in AI, dall'inglese Artificial Intelligence), si intende generalmente l'abilità

di un software di svolgere funzioni e ragionamenti tipici della mente umana.

L'AI (intelligenza artificiale) è quella disciplina che cerca di creare macchine

che in qualche senso possiamo definire intelligenti. L’intelligenza artificiale

è lo studio delle idee che permettono agli elaboratori elettronici di seguire

quelle azioni che fanno apparire "intelligenti le persone". Sembra più chiaro,

ma il senso a cui prima mi riferivo è ancora piuttosto vago. Possiamo definire

una macchina capace di svolgere azioni del genere intelligente? Se una persona

svolge un calcolo matematico ovviamente si dice che è un'essere intelligente,

mentre sareste disposti ad assentire se definissi intelligente la vostra

calcolatrice tascabile?

E soprattutto cos'è che fa apparire intelligenti le persone? Quindi cos'è

l'intelligenza? Definirla non è così semplice. Per un troppo lungo periodo

l'intelligenza si è considerata come un parametro oggettivo misurabile (vedi le

misurazioni del quoziente intellettivo), ma oggi più che mai ci si rende conto

che l'intelligenza umana è estremamente oscura nei suoi meccanismi ed inserita

in quel sistema estremamente complesso che è il nostro organismo con cui

intrattiene strettissimi rapporti, oltre ad essere funzione anche di quel

sistema incommensurabilmente più vasto che è il mondo di cui fa esperienza.

Howard Gardner prosegue la sua corsa all'isolamento di nuovi tipi di

intelligenza: non abbiamo solo un tipo di intelligenza, quella

logico-linguistica che in genere è quella che viene valutata nelle scuole ma

anche quella musicale o cinestetica (che si riferisce alla grazia e bellezza nei

movimenti). Molti altri studiosi invece la fanno dipendere anche e soprattutto,

contrariamente a quanto si è sempre fatto, dal complesso delle emozioni, da

quello che appunto veniva definito irrazionale.

Che cos'è l'Intelligenza Artificiale

L'obiettivo dell'AI si conentra in poche parole: realizzare sui calcolatori

elettronici programmi che siano intelligenti. In realtà, la scelta dei

calcolatori elettronici non è determinata da una necessità teorica ma dall'

esigenza di costruire intelligenze che funzionino in modo automatico, senza

l'intervento esterno dell'uomo ed attualmente gli elaboratori elettronici sono

le macchine più potenti ed efficienti che si hanno a disposizione per tale

scopo. E' importante soffermarsi sulla qualifica di intelligente applicata a un

programma. In questo caso le cose si complicano perché neppure gli psicologi

sanno con precisione che cosa sia l'intelligenza (anche se spesso la misurano).

Per i ricercatori dell'AI, intelligente è un programma che fornisce una

prestazione che diremmo intelligente qualora fosse esibita da un essere umano.

Attenzione e memoria sono sempre necessarie e senza di esse il pensiero non

potrebbe esistere; ma l'intelligenza è qualcosa di più: è la capacità di porre e

di risolvere problemi almeno parzialmente nuovi, di cui non si conosca a priori

un procedimento risolutivo. Innanzitutto, è chiaro che l'intelligenza non è

posseduta solo dagli esperti e dai geni, ma è patrimonio, in grado diverso, di

tutti gli esseri umani. Inoltre, l'AI ha messo in luce che tante attività

comunissime richiedono una dose di intelligenza a volte insospettata: ad esempio

parlare e comprendere un linguaggio, vedere e riconoscere un oggetto, muoversi

adeguatamente in un ambiente. Quando si parla di prestazioni intelligenti

dobbiamo approfondire il concetto distinguendo i risultati di un'attività

intelligente dai procedimenti mentali seguiti. Molti ricercatori ritengono che

la pietra di paragone di un'intelligenza artificiale siano soltanto i risultati.

In questo senso, sarebbe irrilevante simulare il modo di pensare dell'uomo o

procedere in modo radicalmente diverso; dopotutto, il calcolatore elettronico ha

una struttura ben differente dal cervello umano. Ad una posizione così

comportamentistica si possono muovere diverse obiezioni. Innanzitutto, l'AI non

dovrebbe essere soltanto una tecnologia avanzata, ma anche una disciplina

conoscitiva e quindi la comprensione dei procedimenti mentali umani è importante

almeno quanto le applicazioni immediate. Ma anche chi fosse interessato solo al

versante applicativo non deve dimenticare che la nostra mente, in centinaia di

migliaia di anni di evoluzione naturale, ha raggiunto un ragguardevole stadio di

perfezionamento; e quindi può essere assai produttivo studiarne la struttura

interna per riprodurla sul calcolatore. Contemporaneamente, si potrebbe

obiettare che la comprensione dell'intelligenza umana è un obiettivo troppo

ristretto per l'AI, il cui vero oggetto d'indagine dovrebbe essere

l'intelligenza generale ovvero, qualunque procedimento di elaborazione

intelligente dell'informazione, indipendentemente dalla forma che tale

elaborazione ha assunto nella mente dell'uomo.

La distinzione fra intelligenza artificiale forte e debole risulta il fronte di

battaglia concettuale in seno alla concezione classica. Riguarda il modo di

concepire l'IA, e per questo secondo me può essere proficuo applicarlo anche al

campo connessionista ovviamente con le dovute modificazioni del caso.

L’A.I. FORTE presuppone che ogni operazione della nostra mente sia riducibile a

un calcolo. Il nostro pensiero quindi non è altro che una manipolazione di

simboli secondo regole, cosa che il computer sa fare benissimo. Quindi un

elaboratore può raggiungere un livello di intelligenza considerata ad un livello

qualitativo pari a quella umana, dello stesso tipo. Alla base di questa tesi sta

la credenza che il cervello sia al pari di un computer un sistema formale, o

meglio che il ragionamento non sia altro che un calcolo inteso come

manipolazione di simboli. Questa idea sarà descritta nella sezione

sull'Intelligenza Artificiale classica

Per L’ A.I. DEBOLE un calcolatore non potrà mai ottenere un’intelligenza degna

di tale nome ma al massimo potrà simularci imperfettamente. Per l'IA debole un

calcolatore potrebbe anche svolgere alcune o tutte quelle

operazioni e compiti che sono prerogativa dell'essere umano (riconoscere

volti, dialogare in linguaggio naturale, prendere decisioni, ecc.) e

potrebbe farlo anche benissimo, ma questo non significa che sia veramente

intelligente o che ci sia qualche analogia tra computer e mente. .

L'esomorfismo fra "information bases" ed elementi compatti dei domini di Scott

ricade nel quadro generale delle dualità di Stone.

Le dualità di Stone permettono di descrivere speciali classi di spazi topologici

per mezzo di ordini parziali (possibilmente finitari).

Questi ordini parziali sono definiti per mezzo di una topologia e di una sua

base o sottobase. La proprietà principale è la dualità tra le categorie degli

spazi di Stone e quella delle algebre booleane.

Altri esempi di dualità sono le descrizioni dei domini di Scott tramite gli

information sytem e la descrizione dei domini SFP come pre-locali. E non bisogna

dimenticare l'interpetazione data da Martin-Lof della teoria dei tipi

intuizionista nella teoria dei domini.

Abrasky ha spiegato le dualità di Stone usando la teoria dei "frames" e

inquadrandole nella più ampia prospettiva della "teoria dei domini in forma

logica".

I tipi intersezione possono essere visti come una restrizione della descrizione

dei domini in forma logica al caso particolare di reticoli completi

omega-algebrici

tipi in interazione sono usati come potente strumento sia per l'analisi sia per

la sintesi di modelli a filtro per i lambda calcoli non tipati.)

In questo approccio, un modello è descritto in modo finitario da un sistema per

assegnare tipi a termini, e differenti modelli possono essere ottenuti

scegliendo particolari ordini parziali sull'insieme dei tipi, che si riflettono

in una corrispondente regola di inferenza di tipo (sussunzione).

Il sistema di assegnazione dei tipi ai termini corrispondenti a un modello

fornisce una definizione induttiva finitaria dell'interpretazione dei termini

stessi nel modello, in quanto l'interpretazione di un termine è l'insieme dei

tipi che si possono dedurre per esso.

Questo può essere espresso dallo slogan: "il significato di un programma è

l'insieme di tutte le proposizioni vere che lo riguardano".

I tipi possono suggerire la forma che il modello deve possedere per evidenziare

particolari proprietà dei termini.

I tipi intersezione sono un flessibile strumento per dimostrare la consistenza

di lamb, teorie, la facilita’ di termini del lambda calcolo e l'esistenza di

termini che rappresentano operatori di dominio.

Con I.A. lo scopo di questa disciplina sarebbe stato quello di "far fare alle

macchine delle cose che richiederebbero l'intelligenza se fossero fatte dagli

uomini".

L'IA, come viene studiata oggigiorno, tratta dell'individuazione dei modelli

(appropriata descrizione del problema da risolvere) e degli algoritmi (procedura

effettiva per risolvere il modello).

Questa formulazione viene studiata con differenti sapori e con approcci

differenti. Ognuno dei due aspetti (modellizzazione o algoritmico) ha via via

maggiore o minore importanza e varia lungo uno spettro abbastanza ampio.

Le attività e le capacità dell'Intelligenza Artificiale comprendono:

a) il machine learning

b) la e il in maniera simile a quanto fatto dalla mente umana

c) la pianificazione (planning)

d) la cooperazione tra, sia che ()

e) il' Natural Language Processing

d) la simulazione della visione e dell'interpretazione di immagini.

RETI NEURALI

RETI NEURALI

La struttura cellulare del cervello e la sua fisiologia .

Studiare la struttura biologica e la fisiologia del cervello è un compito tutt'altro

che facile. Tuttavia a partire dall'inizio del nostro secolo sono stati fatti

dei grandissimi passi in avanti in questo campo. Oggi disponiamo di

apparecchiature, come la TAC, che ci consentono di ottenere immagini dettagliate

del cervello in attività. E molte conoscenze sono venute anche studiando i danni

e le disfunzioni riportate da persone cerebrolese.

In questo modo i neuroscienziati sono riusciti a capire che tutte le attività

intelligenti sono controllate dalla parte esterna del cervello, quella parte

caratterizzata da un superficie involuta di colore grigiastro e chiamata

corteccia cerebrale. E sappiamo anche che la corteccia è a sua volta divisa in

diverse regioni specializzate: ogni regione controlla una determinata facoltà

cognitiva. Ma le conoscenze sul cervello non si fermano qui. I neuroscienziati,

infatti, sono riusciti a ricostruire anche la struttura cellulare del cervello e

a capirne almeno in parte il funzionamento.

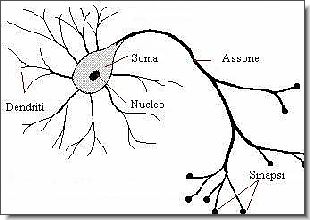

Il cervello è costituito da un enorme insieme di cellule, denominate neuroni. I

neuroni sono costituiti da un corpo centrale o soma, dal quale si dipartono una

serie di prolungamenti filiformi; alcuni di questi prolungamenti sono piuttosto

'corti' e terminano a loro volta in strutture fortemente ramificate: essi sono

denominati dendriti. Uno dei prolungamenti invece è molto più lungo degli altri

(talvolta, come avviene nelle cellule collegate direttamente agli organi

sensoriali esso può estendersi persino per diverse decine di centimetri) e si

chiama assone. Anche l'assone termina in una o più 'code' alla cui estremità si

trova una sorta di rigonfiamento, detto sinapsi. Ogni neurone è collegato

mediante le sue terminazioni sinaptiche ai dendriti di molti altri neuroni. In

questo modo i neuroni, che nel cervello umano sono circa dodici miliardi,

formano un reticolo di interconnessioni fittissimo: secondo alcune stime il

numero di connessioni possibili (che ovviamente non sono pari a quelle realmente

esistenti) sarebbe superiore al numero degli atomi nell'universo!

Ma come funzionano queste cellule ed in che modo determinano l'attività del

cervello? Ebbene, si è scoperto che i neuroni comunicano tra loro scambiandosi

dei segnali elettrici e attivandosi reciprocamente. Il rilascio di un segnale da

parte di un neurone non è automatico e immediato: affinché avvenga è necessario

che il neurone venga eccitato da altri neuroni fino al superamento di una certa

soglia; solo allora la cellula invia un segnale agli altri neuroni con cui è

collegata. I segnali in uscita da un neurone viaggiano sotto forma di minuscoli

impulsi elettrici cha vanno dal nucleo della cellula, lungo l'assone, fino alle

sinapsi. Quando le cariche giungono alle terminazioni sinaptiche esse inducono

la liberazione di particolari molecole dette neurotrasmettitori; queste a loro

volta raggiungono le terminazioni dendritiche dei neuroni collegati all'assone,

e scatenano una reazione chimica che permette il passaggio del segnale elettrico

da un neurone all'altro.

Studiando l'attività biochimica dei neuroni mediante dei raffinati sistemi di

rilevamento, si è notato che ogni diversa facoltà cognitiva e locomotoria

corrisponde ad una aumento di attività in particolari aree del cervello. Si

suppone perciò che il cervello abbia una struttura modulare: ogni modulo è

specializzato per un certo tipo di attività.

Le ricerche di impostazione connessionista hanno cercato di emulare il

comportamento delle cellule neuronali facendo ricorso alle cosiddette reti

neurali:

Una rete neurale è una struttura formata da un certo numero di unità collegate

tra loro da connessioni. Attraverso le connessioni un'unità influenza

fisicamente le altre unità con cui è collegata. Le unità neurali hanno alcune

caratteristiche essenziali delle similicellule nervose, mentre le connessioni

alcune delle caratteristiche essenziali dei collegamenti sinaptici tra neuroni.

Una rete neurale è costituita da un insieme di nodi collegati. Per ogni nodo vi

sono dei collegamenti di input (da cui arrivano segnali) e dei collegamenti di

output (attraverso cui la rete emettte segnali). I nodi possono assumere due

stati: stato di riposo e stato di attivazione. Quando un nodo è in stato di

attivazione esso invia dei segnali ai nodi con cui è collegato. Un aspetto

importante della microfisiologia cerebrale che viene emulato dalle reti neurali

è il sistema di eccitazione. Infatti i collegamenti tra i nodi di una rete

neurale sono di due tipi: collegamenti eccitatori e collegamenti inibitori. Ogni

collegamento tra un nodo della rete e un altro, inoltre, è dotato di un peso. Il

peso del collegamento che assegna diversi valori ai segnali che li attraversano.

Ogni nodo diventa attivo e dunque manda un segnale ai nodi ad esso connessi solo

se i messaggi che gli arrivano (nel computo tra segnali inibitori e segnali

eccitatori) lo portano oltre una certa soglia di attivazione (misurata mediante

una scala numerica). Visto nel suo complesso, il comportamento di una rete

neurale può essere descritto come un processo in cui, una volta fornita in

ingresso alla rete una configurazione di segnali-stimolo (mediante l'attivazione

di alcuni suoi nodi, detti nodi in input), la rete rilascia in uscita un'altra

configurazione di segnali.

Le reti neurali si differenziano in base alla loro architettura, cioè in base al

modo in cui i nodi si dispongono su uno o più strati: in particolare si

distinguono reti a uno strato, reti a due strati reti a tre o più strati. In

questi ultimi due tipi gli strati esterni svolgono rispettivamente la funzione

di strato di input e strato di output, un po' come nel cervello ci sono cellule

che sono in contatto diretto con gli organi di senso e cellule che governano il

movimento e l'emissione di messaggi vocali.

Un altro aspetto che differenzia le reti neurali è rappresentato dalla tipologia

delle connessioni tra i nodi: in alcuni casi le connessioni viaggiano solo in un

senso; in altri, i messaggi possono andare sia in avanti sia indietro; in altri

ancora, nodi topologicamente distanti possono avere dei collegamenti diretti.

Dal punto di vista della implementazione, una rete neurale può essere simulata

interamente 'via software' mediante un normale calcolatore digitale; oppure può

essere realizzata direttamente a livello hardware, mediante la connessione di

molti semplici microprocessori in grado di lavorare in parallelo.

Quali proprietà hanno le reti neurali che le rendono, oltre che un modello (a

dire il vero ancora 'alla lontana') del cervello, un possibile modello dei

comportamenti intelligenti?

Una prima proprietà interessante è che le reti neurali, a differenza dei

computer digitali, funzionano in modalità parallela, nel senso che in ogni

istante molti nodi cambiano il loro stato simultaneamente. Questo tipo di

elaborazione sembra essere molto più aderente al funzionamento reale del

cervello rispetto al modello di elaborazione sequenziale proprio delle macchine

di Turing e Von Neumann. Ma la proprietà più interessante delle reti neurali è

la loro capacità di apprendimento: esse cioè possono imparare a svolgere dei

compiti senza bisogno di essere programmate esplicitamente.

Il processo di apprendimento avviene in questo modo: per un dato periodo di

tempo vengono forniti alla rete una serie di stimoli in entrata e i

corrispondenti stimoli in uscita che essa dovrebbe generare. Ad esempio, in

entrata vengono fornite le rappresentazioni in formato bitmap dei caratteri di

un certo sistema di scrittura, e in uscita le corrispondenti posizioni della

tavola ASCII . Durante questo periodo nella rete vengono modificati i pesi

assegnati ai collegamenti tra nodi. Superata un certa soglia di

autorganizzazione interna la rete è in grado di riconoscere da sola le

configurazioni di input: essa ha cioè imparato a riconoscere i caratteri della

scrittura.

Un'altro aspetto estremamente interessante delle reti neurali (soprattutto in

relazione al discorso sui fondamenti dell'intelligenza artificiale classica e

sulla teoria rappresentazionale della mente) è che in esse la conoscenza

necessaria a svolgere un dato compito non è rappresentata da simboli distinti

che vengono trasformati in base a regole, ma è diffusa tra tutti i nodi della

rete che concorrono ad elaborala. In altri termini, la conoscenza insita in una

rete neurale e la sua elaborazione sono subsimboliche.

Anche da questa nostra breve trattazione, appaiono evidenti le ragioni in virtù

delle quali si afferma che il connessionismo rappresenti un paradigma teorico

radicalmente diverso dalla teoria computazionale classica: esso in primo luogo

sostiene che per ottenere un comportamento intelligente è necessario emulare la

struttura fisica (cellulare per la precisione) del cervello; ma soprattutto

sostiene che i processi cognitivi e, inter alia, il pensiero, non sono il

prodotto di processi computazionali simbolici, ma emergono dal comportamento

complessivo di moltissime unità subsimboliche che, prese singolarmente, non

rappresentano niente.

Sulla base di questo paradigma, la cui prima formulazione risale ad un

lungimirante saggio di W. McCulloch e W. Pitt risalente al 1943 (W. McCulloch e

W. Pitt, "A Logical Calculus of the Ideas Immanent in Nervous Activity", in Bul.

Math Biophys, sono state realizzate numerose applicazioni delle reti neurali in

vari domini: per esempio nella simulazione dei comportamenti elementari di

specie inferiori, spesso associata alla costruzione di robot reali. In questo

settore specifico il primo esperimento importante è stato il Perceptron di

Rosenblatt (1958) che era un robot in grado di muoversi in un ambiente evitando

gli ostacoli. Un altro settore in cui il paradigma connessionista ha avuto larga

diffusione è quello dello studio e della emulazione dei processi soggiacenti

alla percezione, ambito nel quale l'impostazione computazionale classica ha

mostrato notevoli limiti. E non sono mancate anche le applicazioni pratiche,

soprattutto nel campo dei software per il riconoscimento dei caratteri (OCR, su

cui ci siamo soffermati nel primo capitolo), e, negli ultimi anni, anche nel

campo dell'analisi finanziaria.

Intorno a queste sperimentazioni, poi, è proliferata una ingente mole di

letteratura teorica e filosofica che considera il connessionismo la strada

maestra per la creazione di macchine intelligenti e per lo studio

dell'intelligenza naturale. Naturalmente i sostenitori dell'IA classica e della

teoria rappresentazionale hanno reagito, producendo una pari mole di

confutazioni delle tesi connessioniste. E in realtà, sebbene il connessionismo

abbia riportato dei buoni successi nei domini che abbiamo appena ricordato,

quando si è tentato di applicarlo alla riproduzione artificiale delle facoltà

cognitive superiori ha rivelato non pochi limiti. Infatti, è innegabile che

molte di queste attività consistano in qualche specie di elaborazione simbolica

(non necessariamente di tipo computazionale): e finora nessuno è stato in grado

di capire come dalla concorrenza di moltissimi processi di elaborazione

paralleli e subsimbolici possa effettivamente emergere una qualche forma di

elaborazione simbolica, come la competenza linguistica o la capacità di

ragionare in modo deduttivo.

Per questa ragione molti studiosi sono convinti che se una prospettiva di

sviluppo e di successo per l'intelligenza artificiale esiste veramente, questa

scaturirà dalla convergenza tra il modello computazionale e modello

connessionista. Infatti i processi che avvengo nel cervello, almeno allo stato

attuale delle conoscenze, sembrano disporsi su vari livelli: ai livelli bassi

(che corrispondo alla percezione e ai processi di elaborazione degli stimoli

provenienti dall'ambiente) avvengono molte elaborazioni veloci e parallele di

elementi subsimbolici; ai livelli alti invece si collocano dei processi che

trasformano l'output dei livelli bassi in simboli e con tali simboli eseguono

quelle elaborazioni che la Buona Vecchia IA ha studiato da mezzo secolo ai

giorni nostri.

L'intelligenza artificiale classica utilizza il paradigma simbolico per

affrontare problemi considerati di alto livello.

L'approccio classico non riesce però ad affrontare problemi apparentemente

semplici, quali il meccanismo di volo di una mosca.

Le funzioni biologiche e cognitive che sembravano più elementari si sono

dimostrate essere più difficili di quanto si pensasse, più complesse di funzioni

considerate di alto livello; soprattutto, tali funzioni sono estremamente

difficili da simulare con l'approccio computazionale classico.

Simulare il S.N.C.

Poiché i sistemi nervosi biologici sono in numerose circostanze più potenti dei

sistemi computazionali classici, si è cercato di simularne le potenzialità

riproducendo alcuni aspetti della loro architettura fisica.

L'architettura biologica

L'approccio connessionista è sorto dall'ipotesi che la capacità dimostrata dai

sistemi biologici ad affrontare compiti complessi fosse dovuta all'architettura

fisica del loro sistema nervoso. Si è dunque tentato di creare delle

architetture fisiche che riproducessero, in maniera semplificata, alcune delle

caratteristiche del S.N.C.

Un differente paradigma computazionale.

Le macchine di von Neumann sono basate su un'astrazione di elaborazone e memoria

del ragionamento umano;

Le reti neurali sono basate sull'architettura parallela del cervello biologico

Gli aspetti considerati salienti sono:

numerosità - parallelismo: le reti neurali biologiche sono composte da un numero

elevatissimo di unità che lavorano in parallelo

connettività: le unità sono fra loro altamente connesse

Altre caratteristiche salienti

unità computazionali semplici;

alto grado di connettività;

utilizzo di messaggi (relativamente) semplici;

interazione adattiva fra elementi.

Le potenzialità delle reti

Le caratteristiche biologiche dei neuroni, la loro numerosità e la loro

connettività permettono l'emergere di alcune caratteristiche molto importanti

Risposta continua ad esclusione di un numero finito di discontinuità ad input

simili la rete risponde con output simili.

Tolleranza agli errori

scostamenti non significativi dei valori di input vengono assorbiti dalla rete,

diminuendo così il rumore statistico e risultando tolleranti agli errori o al

decadimento del segnale.

Tolleranza ai guasti

La presenza di molte unità di processamento parallele l'eventuale perdita di un

unità ha, nel caso di architetture con molti neuroni, conseguenze non

irreparabili.

Capacità di apprendimento

Attraverso degli opportuni algoritmi di modificazione dinamica dei pesi la rete

riesce ad adattare il proprio comportamento fino a computare una funzione

arbitraria y= f (x) in base agli esempi presentati.

Capacità di generalizzare

Grazie al fatto che la risposta delle reti è continua (ad esclusione di un

numero finito di discontinuità) il sistema che abbia correttamente appreso una

funzione riesce di norma a fornire una risposta "ragionevole" anche a stimoli

precedentemente mai occorsi.

Livelli di descrizione

Livello biologico - neurofisiologico

Livello matematico

Livello fisico

Livello statistico

Intelligenza artificiale

Modelli psicologici e neuropsicologici

Livello biologico - neurofisiologico

Le reti neurali artificiali costituiscono delle metafore delle reti neurali

biologiche;

nell'ambito delle "neuroscienze computazionali" le reti costituiscono dei

modelli teorici di aree funzionali del sistema nervoso centrale.

Livello matematico

Le reti sono oggetti matematici, in quanto vengono realizzate attraverso degli

stumenti matematici classici;

esse sono, a loro volta, degli strumenti matematici, in quanto calcolano delle

funzioni arbitrarie.

Livello fisico

Alcune architetture di reti neurali artificiali presenti in letteratura

costituiscono dei modelli di alcuni dominî fisici. L'esempio più significativo è

costituito dalle reti di Hopfield, che simulano il comportamento

elettromagnetico dei metalli.

Livello statistico

i percettroni senza strati nascosti costituiscono dei modelli lineari;

le reti con uno strato nascosto sono paragonabili a dei modelli di regressione;

le reti neurali probabilistiche corrispondono alla kernel discriminant analysis;

le reti di Kohonen di quantizzazione vettoriale adattiva sono simili alla

cluster analisys;

la regola di Hebb è correlata all'analisi delle componenti principali;

Intelligenza artificiale

Le reti neurali possono realizzare degli strumenti, e vengono usate in numerosi

contesti, proprio perché capaci di affrontare problemi complessi e poco o male

strutturati sotto il profilo formale

Modelli psicologici e neuropsicologici

Se la simulazione vale esclusivamente a livello di corrispondenza input-output

la rete costituisce un modello psicologico; qualora l'architettura della rete

corrisponde a dei moduli funzionali che si assume siano coinvolti in un processo

cognitivo possiamo parlare di simulazione di modelli neuropsicologici.

Gli aspetti considerati salienti sono:

numerosità - parallelismo: le reti neurali biologiche sono composte da un numero

elevatissimo di unità che lavorano in parallelo

connettività: le unità sono fra loro altamente connesse

Altre caratteristiche salienti

unità computazionali semplici;

alto grado di connettività;

utilizzo di messaggi (relativamente) semplici;

interazione adattiva fra elementi.

Le potenzialità delle reti

Le caratteristiche biologiche dei neuroni, la loro numerosità e la loro

connettività permettono l'emergere di alcune caratteristiche molto importanti

Risposta continua

ad esclusione di un numero finito di discontinuità ad input simili la rete

risponde con output simili

Tolleranza agli errori

scostamenti non significativi dei valori di input vengono assorbiti dalla rete,

diminuendo così il rumore statistico e risultando tolleranti agli errori o al

decadimento del segnale.

Tolleranza ai guasti

La presenza di molte unità di processamento parallele l'eventuale perdita di un

unità ha, nel caso di architetture con molti neuroni, conseguenze non

irreparabili.

Capacità di apprendimento

Attraverso degli opportuni algoritmi di modificazione dinamica dei pesi la rete

riesce ad adattare il proprio comportamento fino a computare una funzione

arbitraria y= f (x) in base agli esempi presentati.

Capacità di generalizzare

Grazie al fatto che la risposta delle reti è continua (ad esclusione di un

numero finito di discontinuità) il sistema che abbia correttamente appreso una

funzione riesce di norma a fornire una risposta "ragionevole" anche a stimoli

precedentemente mai occorsi

Approccio trasformazionale: un linguaggio viene definito come ottenuto

sottoponendo a una data trasformazione un altro linguaggio, tendenzialmente più

semplice. Fondamenti biologici

In quasi tutti gli organismi viventi sono presenti complesse organizzazioni di

cellule nervose, con compiti di riconoscimento delle configurazioni assunte

dall'ambiente esterno, memorizzazione e reazione agli stimoli provenienti dallo

stesso. Il cervello umano rappresenta probabilmente il più mirabile frutto

dell'evoluzione per le sue capacità di elaborare informazioni. Al fine di

compiere tali operazioni, le reti biologiche si servono di un numero imponente

di semplici elementi computazionali (neuroni) fittamente interconnessi in modo

da variare la loro configurazione in risposta agli stimoli esterni: in questo

senso può parlarsi di ed i modelli artificiali cercano di catturare questo

tratto distintivo della biologia.

Tipicamente un è costituito di 3 parti principali: il (corpo cellulare), l'

(linea di uscita del neurone unica ma che si dirama in migliaia di rami) e il

(linea di entrata del neurone che riceve segnali in ingresso da altri assoni

tramite ). Il corpo cellulare fa una "somma pesata" dei segnali in ingresso. Se

il risultato eccede un certo valore di soglia allora il neurone si attiva ed è

prodotto un "potenziale di azione" che è mandato all'assone. Se il risultato non

eccede il valore di soglia, il neurone rimane in uno stato di riposo. Una rete

neurale artificiale riceve segnali esterni su uno strato di nodi (unità di

elaborazione) d'ingresso, ciascuno dei quali è collegato con numerosi nodi

interni, organizzati in più livelli. Ogni nodo elabora i segnali ricevuti e

trasmette il risultato a nodi successivi.

Funzionamento di una rete neurale

Le reti neurali si basano principalmente sulla simulazione di artificiali

opportunamente collegati.

I suddetti neuroni ricevono in ingresso degli stimoli e li elaborano.

L'elaborazione può essere anche molto sofisticata ma in un caso semplice si può

pensare che i singoli ingressi vengano moltiplicati per un opportuno valore

detto peso, il risultato delle moltiplicazioni viene sommato e se la somma

supera una certa soglia il si attiva attivando la sua uscita. Il peso indica

l'efficacia sinaptica della linea di ingresso e serve a quantificarne

l'importanza, un ingresso molto importante avrà un peso elevato, mentre un

ingresso poco utile all'elaborazione avrà un peso inferiore. Si può pensare che

se due neuroni comunicano fra loro utilizzando maggiormente alcune connessioni

allora tali connessioni avranno un peso maggiore.

I singoli neuroni vengono collegati alla schiera di neuroni successivi, in modo

da formare una rete di neuroni. Normalmente una rete è formata da tre strati.

Nel primo abbiamo gli ingressi (I), questo strato si preoccupa di trattare gli

ingressi in modo da adeguarli alle richieste dei neuroni. Se i segnali in

ingresso sono già trattati può anche non esserci. Il secondo strato è quello

nascosto (H, hidden), si preoccupa dell'elaborazione vera e propria e può essere

composto anche da più colonne di neuroni. Il terzo strato è quello di uscita (O)

e si preoccupa di raccogliere i risultati ed adattarli alle richieste del blocco

successivo della rete neurale. Queste reti possono essere anche molto complesse

e coinvolgere migliaia di neuroni e decine di migliaia di connessioni.

una quantità di studi e ricerche, e suscita un vivo interesse e notevoli

aspettative nella comunità scientifica, destinate tuttavia ad essere

notevolmente ridimensionate allorché nel mostrano i limiti operativi delle

semplici reti a due strati basate sui percettroni, e dimostrano l'impossibilità

di risolvere per questa via molte classi di problemi, ossia tutti quelli non

caratterizzati da separabilità lineare delle soluzioni: questo tipo di rete

neurale non è abbastanza potente, infatti non è in grado di calcolare neanche la

funzione or esclusivo (). Di conseguenza, a causa di queste limitazioni, ad un

periodo di euforia per i primi risultati della (come veniva chiamata negli ),

segue un periodo di diffidenza durante il quale tutte le ricerche in questo

campo non ricevono più alcun finanziamento dal governo degli ;le ricerche sulle

reti tendono, di fatto, a ristagnare per oltre un decennio, e l'entusiasmo

iniziale risulta fortemente ridimensionato.

L'algoritmo di apprendimento si basa sul metodo della che permette di trovare un

minimo locale di una funzione in uno a N . I pesi associati ai collegamenti tra

gli strati di neuroni si inizializzano a valori piccoli e casuali e poi si

applica la regola di apprendimento presentando alla rete dei pattern di esempio.

Queste reti neurali sono capaci di generalizzare in modo appropriato, cioè di

dare risposte plausibili per input che non hanno mai visto.

L'addestramento di une rete neurale di tipo BP avviene in due diversi stadi:

forward-pass e backward-pass. Nella prima fase i vettori in input sono applicati

ai nodi in ingresso con una propagazione in avanti dei segnali attraverso

ciascun livello della rete (forward-pass). Durante questa fase i valori dei pesi

sinaptici sono tutti fissati. Nella seconda fase la risposta della rete viene

confrontata con l'uscita desiderata ottenendo il segnale d'errore. L'errore

calcolato è propagato nella direzione inversa rispetto a quella delle

connessioni sinaptiche. I pesi sinaptici infine sono modificati in modo da

minimizzare la differenza tra l'uscita attuale e l'uscita desiderata (backward-pass).

Questo algoritmo consente di superare le limitazioni del percettrone e di

risolvere il problema della separabilità non lineare (e quindi di calcolare la

funzione ), segnando il definitivo rilancio delle reti neurali, come

testimoniato anche dall'ampia varietà d'applicazioni commerciali: attualmente la

BP rappresenta un algoritmo di largo uso in molti campi applicativi.

Reti di Hopfield

Nel , il fisico pubblica un articolo fondamentale in cui presenta un modello

matematico comunemente noto appunto come rete di Hopfield: tale rete si

distingue per "l'emergere spontaneo di nuove capacità computazionali dal

comportamento collettivo di un gran numero di semplici elementi d'elaborazione".

Le proprietà collettive del modello producono una memoria associativa per il

riconoscimento di configurazioni corrotte e il recupero di informazioni

mancanti.

Tra le nuove idee messe in luce da Hopfield, quella più degna di menzione

riguarda il capovolgimento del rapporto, fino allora esistente, tra calcolo e

numeri: mentre era universalmente noto che il calcolo producesse numeri, assai

meno banale era l'osservazione di Hopfield che, viceversa, anche i numeri

potessero spontaneamente generare calcolo, e che questo potesse emergere quale

attributo collettivo di sistemi interattivi siffatti.

Una rete ricorrente è un modello neurale in cui è presente un flusso

bidirezionale d'informazioni; in altri termini, mentre nelle reti di tipo

feedforward la propagazione dei segnali avviene unicamente, in maniera continua,

nella direzione che conduce dagli ingressi alle uscite, nelle reti ricorrenti

tale propagazione può anche manifestarsi da uno strato neurale successivo ad uno

precedente, oppure tra neuroni appartenenti ad uno stesso strato, e persino tra

un neurone e sé stesso.

Reti di Elman

Un significativo e noto esempio di semplice rete ricorrente è dovuto a (). Essa

costituisce una variazione sul tema del percettrone multistrato, con esattamente

tre strati e l'aggiunta di un insieme di neuroni "contestuali" nello strato

d'ingresso. Le connessioni retroattive si propagano dallo strato intermedio (e

nascosto) a tali unità contestuali, alle quali si assegna peso costante e pari

all'unità.

In ciascun istante, gli ingressi si propagano nel modo tradizionale e tipico

delle reti feedforward, compresa l'applicazione dell'algoritmo d'apprendimento

(solitamente la backpropagation). Le connessioni retroattive fisse hanno come

effetto quello di mantenere una copia dei precedenti valori dei neuroni

intermedi, dal momento che tale flusso avviene sempre prima della fase

d'apprendimento.

Gli algoritmi per il reinforcement learning tentano in definitiva di determinare

una politica tesa a massimizzare gli incentivi cumulati ricevuti dall'agente nel

corso della sua esplorazione del problema. L'apprendimento con rinforzo

differisce da quello supervisionato poiché non sono mai presentate delle coppie

input-output di esempi noti, né si procede alla correzione esplicita di azioni

subottimali. Inoltre, l'algoritmo è focalizzato sulla prestazione in linea, la

quale implica un bilanciamento tra esplorazione di situazioni ignote e

sfruttamento della conoscenza corrente.

Algoritmo di Backpropagation

L'algoritmo di backpropagation è utilizzato nell'apprendimento con supervisione.

Esso permette di modificare i pesi delle connessioni in modo tale che si

minimizzi una certa funzione errore E. Tale funzione dipende dal vettore h-esimo

di output restituito dalla rete, dato il vettore h-esimo di ingresso e dal

vettore h-esimo di output che noi desideriamo (che fa parte del training set).

Il training set è dunque un insieme di N coppie di vettori , con h = 1,...,N. La

funzione errore che si deve minimizzare si può scrivere come: , dove l'indice k

rappresenta il valore corrispondente al k-esimo neurone di output. E è una

funzione dipendente dai pesi (che in generale variano nel tempo). Per

minimizzare E(w) si può usare l'algoritmo della (gradient-descent). L'algortimo

parte da un punto generico e calcola il gradiente . Il gradiente dà la direzione

verso cui muoversi lungo la quale ho il massimo incremento (o decremento se

considero ). Definita la direzione ci si muove di una distanza ç predefinita a

priori e si trova un nuovo punto sul quale è calcolato nuovamente il gradiente.

Si continua iterativamente finché il gradiente non è nullo. L'algoritmo di

backpropagation può essere diviso in due passi:

Forward pass: l'input dato alla rete è propagato al livello successivo e così

via ai livelli successivi (il flusso di informazioni si sposta in avanti, cioè

forward). Si calcola dunque E(w), l'errore commesso.

Backward pass: L'errore fatto dalla rete è propagato all'indietro (backward) e i

pesi sono aggiornati in maniera appropriata.

Durante la fase di addestramento si costruisce la mappa, pertanto la rete si

configura ed organizza tramite un processo competitivo. Alla rete deve essere

fornito il numero più grande possibile di vettori in ingresso, tali da

rappresentare fedelmente la tipologia di vettore che le sarà eventualmente

sottoposta nella seconda fase;

nel corso della seconda fase ogni nuovo vettore d’ingresso può essere

velocemente classificato o categorizzato, collocandolo in automatico sulla mappa

ottenuta nella fase precedente. Vi sarà sempre un unico neurone vincente, quello

il cui vettore dei pesi giace a minor distanza dal vettore appena sottoposto

alla rete; tale neurone può essere determinato semplicemente calcolando la

distanza euclidea tra i due vettori in questione.

Pregi

Le reti neurali per come sono costruite lavorano in parallelo e sono quindi in

grado di trattare molti dati. Si tratta in sostanza di un sofisticato sistema di

tipo statistico dotato di una buona immunità al ; se alcune unità del sistema

dovessero funzionare male, la rete nel suo complesso avrebbe delle riduzioni di

prestazioni ma difficilmente andrebbe incontro ad un blocco del sistema. I

software di ultima generazione dedicati alle reti neurali richiedono comunque

buone conoscenze statistiche; il grado di apparente utilizzabilità immediata non

deve trarre in inganno, pur permettendo all'utente di effettuare da subito

previsioni o classificazioni, seppure con i limiti del caso. Da un punto di

vista industriale, risultano efficaci quando si dispone di dati storici che

possono essere trattati con gli algoritmi neurali. Ciò è di interesse per la

produzione perché permette di estrarre dati e modelli senza effettuare ulteriori

prove e sperimentazioni.

Difetti

I modelli prodotti dalle reti neurali, anche se molto efficienti, non sono

spiegabili in linguaggio simbolico umano: i risultati vanno accettati "così come

sono", da cui anche la definizione inglese delle reti neurali come "black box".

Come per qualsiasi algoritmo di modellazione, anche le reti neurali sono

efficienti solo se le variabili predittive sono scelte con cura. Non sono in

grado di trattare in modo efficiente variabili di tipo categorico (per esempio,

il nome della città) con molti valori diversi. Necessitano di una fase di

addestramento del sistema che fissi i pesi dei singoli Neuroni e questa fase può

richiedere molto tempo, se il numero dei record e delle variabili analizzate è

molto grande. Non esistono teoremi o modelli che permettano di definire la rete

ottima, quindi la riuscita di una rete dipende molto dall'esperienza del

creatore.

AGIRE IN MODO RAZIONALE

Agire in modo

razionale

Agire razionalmente significa agire per raggiungere i propri obiettivi, date le

proprie credenze. Un agente è proprio qualcosa che percepisce e agisce. In

questo approccio l'AI è vista come lo studio e la costruzione di agenti

razionali. Nell'approccio all'AI basato sul 'pensare razionalmente' l'enfasi

veniva totalmente posta sulle inferenze corrette. Talvolta, fare inferenze

corrette fa parte dell'essere un agente razionale, perché un modo di agire

razionalmente consiste nel ragionare logicamente fino a concludere che una certa

azione possa raggiungere i propri obiettivi, e quindi agire sulla base di tale

conclusione. D'altro canto, un'inferenza corretta non è completamente razionale,

perché esistono spesso situazioni in cui non c'è alcuna cosa da fare che si

riesce a dimostrare corretta, anche se bisogna fare comunque qualcosa. Ci sono

anche modi di agire razionalmente in cui non si può dire ragionevolmente che

siano coinvolte delle inferenze. Ad esempio, ritrarre la propria mano da un

fornello caldo è un riflesso condizionato che ha maggior successo di un'azione

più lenta compiuta dopo un'attenta deliberazione. Tutte le "capacità cognitive"

necessarie per il test di Turing sono utili per consentire azioni razionali.

Perciò, abbiamo bisogno delle capacità di rappresentare la conoscenza e di

ragionarci perché questo ci consente di pervenire a decisioni buone in un'ampia

varietà di situazioni. Dobbiamo essere in grado di comporre frasi comprensibili

in linguaggio naturale perché utilizzare queste frasi ci aiuta a vivere in una

società complessa. Abbiamo bisogno dell'apprendimento, non solo per erudizione,

ma perché avere un'idea migliore di come funziona il mondo ci rende in grado di

generare strategie più efficaci per interagire con esso. Abbiamo bisogno della

percezione visiva, non solo perché vedere è divertente, ma per avere un'idea

migliore di cosa si possa raggiungere attraverso un' azione (per esempio, essere

in grado di vedere un cibo appetitoso rappresenta uno stimolo per raggiungerlo).

Lo studio dell' AI vista come progettazione di un agente razionale presenta

quindi due vantaggi. Innanzitutto, è più generale dell'approccio del "pensare

razionalmente" perché fare delle inferenze corrette è solo un meccanismo utile,

ma non necessario, per raggiungere la razionalità. In secondo luogo è più

riconducibile allo sviluppo scientifico rispetto agli approcci basati sull

"agire come un essere umano" o sul "pensare come un essere umano" perché lo

standard della razionalità è definito chiaramente ed è completamente generale.

Bisogna considerare un punto importante: raggiungere la perfetta razionalità non

è sempre possibile soprattutto in ambienti complessi ove le richieste

computazionali sono troppo elevate; in molti casi è opportuno agire con

'razionalità limitata' cioè agire in modo appropriato quando non c'è abbastanza

tempo per fare tutti i calcoli che si desidera.

Le altre discipline

l'AI sia di per sé una disciplina giovane, ha ereditato molte idee, punti di

vista e tecniche da altre discipline. Dalla tradizione filosofica sono emerse

teorie del ragionamento e dell'apprendimento, insieme al punto di vista per cui

la mente è concepita come un meccanismo fisico che:

· opera principalmente attraverso il ragionamento sulla conoscenza che contiene,

· esegue connessioni tra la conoscenza e l'azione,

· giustifica le azioni intraprese,

· acquisisce nuova conoscenza dall'esperienza.

Dalla matematica sono state acquisite teorie formali sulla logica (in

particolare sulla logica del primo ordine usato oggi come maggior sistema di

base per la rappresentazione della conoscenza), sulla probabilità, su come

prendere decisioni e sul calcolo. Dalla psicologia, si hanno gli strumenti con

cui investigare la mente umana e un linguaggio scientifico con il quale

esprimere le teorie risultanti. Dalla linguistica, sono emerse teorie sulla

struttura e sul significato del linguaggio nonché sull'importanza del linguaggio

per rappresentare la conoscenza. Dall'informatica, si hanno strumenti attraverso

cui fare dell'AI una realtà. L'elaboratore elettronico è ritenuto all'unanimità

il sistema artificiale con le migliori possibilità di dimostrare intelligenza.

Con il progresso della ricerca IA e lo sviluppo di tecniche per trattare una

quantità maggiore di conoscenza sul mondo, si è verificato qualche progresso per

quanto riguarda i compiti appena descritti e si sono potuti ragionevolmente

affrontare nuovi compiti. Fra questi, si possono includere la percezione

(visione e discorso), la comprensione del linguaggio naturale, e la risoluzione

di problemi in domini specializzati, come la diagnosi medica e l'analisi

chimica. Attività come la percezione e la comprensione del linguaggio sono

affrontate normalmente quasi da tutti. Oltre a questi compiti quotidiani, molte

persone svolgono altre attività intelligenti in cui sono esperte. Queste cose

come (come ad esempio diagnosticare malattie) sono spesso considerate più

difficili dei compiti quotidiani poiché solo alcune persone sono in grado di

farle. Numerosi problemi di questo tipo si sono dimostrati risolubili da parte

di programmi denominati sistemi esperti. Tratteremo i sistemi esperti

successivamente, per ora ci basta far notare che un sistema esperto è un

programma che simula il modo di operare di un essere umano: ad esempio un medico

che diagnostica una malattia, un chimico che analizza dati di laboratorio, un

ingegnere che progetta un impianto industriale. I sistemi esperti si basano su

tecniche di sviluppo e di programmazione tipiche dell'AI, che consentono di

affrontare con successo problemi troppo ardui per l'informatica tradizionale. In

genere si tratta di sistemi di grande complessità, che fino a pochi anni fa

richiedevano risorse di calcolo molto costose. Tuttavia, il crollo dei prezzi

dello hardware, dovuto alla tecnologia di integrazione su larga scala, ha

cambiato radicalmente la situazione. Oggi esistono sistemi esperti di rilevante

interesse applicativo che funzionano su stazioni di lavoro di costo

relativamente basso, dell'ordine di qualche decina di milioni di lire. Questo

fatto, insieme con il consolidarsi e il. diffondersi delle metodologie dell'AI

ha portando ad un sempre maggiore interesse verso i sistemi esperti. ·

VISIONE ARTIFICIALE

Visione

artificiale

La Visione artificiale è l'insieme dei processi che mirano a creare un modello

approssimato del mondo reale (3D) partendo da immagini bidimensionali (2D). Lo

scopo principale della visione artificiale è quello di riprodurre la vista

umana.

Un è costituito dall’integrazione di componenti ottiche, elettroniche e

meccaniche che permettono di acquisire, registrare ed elaborare immagini sia

nello spettro della luce visibile che al di fuori di essa (infrarosso,

ultravioletto, raggi X, ecc.).

Il risultato dell’elaborazione è il riconoscimento di determinate

caratteristiche dell’immagine per varie finalità di controllo, classificazione,

selezione, ecc.

Queste definizioni indicano quindi quattro possibili obiettivi da perseguire in

intelligenza artificiale e storicamente, sono stati seguiti tutti e quattro gli

approcci:

Sistemi che pensano come gli esseri umani Sistemi che pensano razionalmente

Sistemi che operano come gli esseri umani

Sistemi che agiscono razionalmente

Come ci si può aspettare, c'è un contrasto tra gli approcci basati sugli esseri

umani e quelli basati sulla razionalità. Un approccio centrato sull'uomo deve

costituire una scienza empirica, che comporta ipotesi e conferme sperimentali.

Un approccio razionalista comporta una combinazione di matematica ed ingegneria.

Le persone di ciascun gruppo talvolta denigrano il lavoro fatto negli altri

gruppi, ma la verità è che tutte le direzioni hanno prodotto dei risultati di

valore.

Se vogliamo dire che un dato programma pensa come un essere umano, dobbiamo

avere un modo per determinare come pensano gli esseri umani ed entrare nei

meccanismi reali delle menti umane. Ci sono due modi per fare questo: attraverso

l'introspezione, cercando di afferrare i nostri stessi pensieri man mano che

vengono formulati, o attraverso esperimenti psicologici. Una volta acquisita una

teoria sufficientemente precisa della mente, diviene possibile esprimere la

teoria come un programma. Se il comportamento di ingresso/uscita e di

temporarizzazione del programma si uniformano al comportamento umano, viene

fornita l'evidenza che alcuni dei meccanismi del programma possono operare anche

negli esseri umani. Newell e Simon, che hanno sviluppato ne 1961 GPS, "General

Problem Solver" (dall'inglese, risolutore generale di problemi), non si

accontentarono che il loro programma risolvesse correttamente i problemi, ma

piuttosto erano interessati a confrontare la traccia dei passi del suo

ragionamento con le tracce di soggetti umani che risolvevano gli stessi

problemi. Ciò è in contrasto con altri ricercatori dello stesso periodo che

erano interessati ad ottenere le risposte giuste senza preoccuparsi di come

potessero farlo gli esseri umani. Il campo interdisciplinare della scienza

cognitiva mette insieme modelli informatici dell'AI e tecniche sperimentali

della psicologia per tentare di costruire teorie dei meccanismi della mente

umana verificabili. L'AI e la scienza cognitiva continuano a fertilizzarsi a

vicenda, soprattutto nelle aree della visione, del linguaggio naturale e

dell'apprendimento.

AGIRE COME UN ESSERE UMANO

E’ POSSIBILE

COSTRUIRE MACCHINE CHE

PRODUCONO LE FUNZIONALITA’ DELLA MENTE?

E' possibile riprodurre artificialmente le funzioni dell'intelligenza umana,

costruire macchine che sappiano svolgere gli stessi compiti solitamente affidati

all'uomo (secondo l'ipotesi debole dell'intelligenza artificiale)? E' poi

possibile riprodurre artificialmente non solo le funzioni, ma anche gli stessi

procedimenti dell'intelligenza umana (come sostiene l'ipotesi forte

dell'intelligenza artificiale)?

Se una di queste due cose è possibile, si può costruire una macchina

intelligente, e in questo caso (specie se anche la seconda ipotesi è

realizzabile) diventa probabile che la stessa intelligenza umana si basi

ultimamente su meccanismi analoghi a quelli di una macchina intelligente, e che

il suo funzionamento sia spiegabile meccanicisticamente.

Viceversa, se si dovesse accertare che l'intelligenza umana ha basi meccaniche,

diverrebbe assai probabile che si possano costruire meccanismi in grado di

imitarla. La discussione sull'intelligenza artificiale può dunque partire da

tesi sulle possibilità della tecnologia per giungere a tesi sull'antropologia, o

viceversa. Nel percorso sono coinvolte informatica, psicologia, neurologia e

filosofia della mente.

Tradizionalmente l'intelligenza è stata considerata una prerogativa dell'anima

umana, sicché né animali né macchine, in quanto privi di anima, avrebbero potuto

esserne dotati. Anche nei secoli passati, tuttavia, si sono avute tesi

divergenti rispetto a questa credenza generalizzata, tesi alla luce delle quali

l'intelligenza artificiale si sarebbe potuta considerare possibile. Cruciale, a

questo riguardo, è la questione del rapporto tra anima e corpo: data la loro

radicale eterogeneità (spirituale l'una, materiale l'altro), si tratta di

spiegare come l'anima possa agire sul corpo (ad esempio facendolo muovere in un

modo piuttosto che in un altro) e il corpo sull'anima (ad esempio producendo in

essa sensazioni). Già dai secoli passati si sono quindi delineate due strategie:

o postulare una connessione garantita dall'esterno (ad esempio per opera

divina), oppure attenuare o eliminare la radicale eterogeneità dei due elementi.

Si può ad esempio:

(a) negare l'esistenza del corpo e mantenere solo l'anima, o viceversa

(b) negare l'anima attribuendone tutte le funzioni al corpo, o più semplicemente

(c) rinunciare a considerarla come sostanza separata, presentandola invece come

funzione o manifestazione dell'attività corporea.

Le prospettive (b) e (c) implicano la convinzione che un oggetto materiale

sufficientemente complesso e articolato come il corpo possa svolgere le funzioni

dell'anima o dar vita all'anima come manifestazione di sé (volendo poi precisare

meglio tale idea, come i progressi della ricerca consentivano di fare già ai

pensatori del Seicento, al posto del corpo si può parlare del cervello, o come

oggi si preferisce, del sistema nervoso centrale). Tale concezione, a sua volta,

rende possibile pensare che animali e macchine, dotati di un cervello o di

organi analoghi, possano pertanto sentire, pensare, ed essere intelligenti.

Ecco l'importanza per la discussione sull'intelligenza artificiale del

tradizionale problema filosofico dei rapporti tra anima e corpo, o come oggi più

comunemente si dice, tra mente e corpo o tra mente e cervello ( il termine

mente, infatti, è meno carico di presupposizioni teologiche e metafisiche, e pur

denotando il complesso di tutte le possibili manifestazioni della vita psichica

(sensazioni, sentimenti, pensieri, volizioni ...) non implica di per sé l'idea

di una sostanza separata).

Il lungo dibattito su tale problema ha comunque mostrato che la coscienza

(intesa come consapevolezza soggettiva di sensazioni, pensieri, emozioni, o dei

loro contenuti), pur essendo l'aspetto più caratteristico della vita mentale, è

anche quello che più difficilmente si potrebbe pensare di riprodurre in una

macchina.

Si può allora parlare di intelligenza artificiale anche senza chiedersi se le

macchine possano avere una mente, ma solo se esse possano svolgere quelle

particolari funzioni della mente che hanno a che fare con l'intelligenza; in

altri termini, si può pensare a una macchina intelligente, ma priva di

sensazioni, emozioni, e in sintesi di coscienza.

ESEMPIO

Lezione in classe; lettura a casa almeno di brani antologici selezionati, e se

con maggior disponibilità di tempo singole opere o articoli; susseguente

discussione in classe. Gli studenti sono stimolati (e possono essi stessi

stimolare il docente) al confronto con quanto suggerito dall’esperienza che

stanno compiendo parallelamente di programmazione per il problem-solving: in che

senso le piccole “macchine” che stanno costruendo (i programmi che scrivono)

pensano? In che senso sono intelligenti? A che condizioni si potrebbe parlare di

una “mente” di tali macchine?

Estratto da ""

REALTA' VIRTUALE

REALTA’ VIRTUALE

Un'adeguata rappresentazione dell'ambiente circostante è uno degli aspetti

salienti degli esseri adattativi. Il modo in cui un essere adattativo costruisce

ed una una rappresentazione interna dello spazio dipende dalle sue competenze

rappresentazionali e dal tipo di interazione occorsa fra il soggetto e

l'ambiente. E' ragionevole assumere che il modo in cui un soggetto interagisce

con l'ambiente influenza la sua rappresentazione.

Nel testare delle ipotesi concernenti la rappresentazione dell'ambiente è

necessario affrontare molteplici problemi pratici: è necessario condurre gli

esperimenti in ambienti non noti ai soggetti. Gli edifici sono arredati e dunque

dispongono di etichette e landmarks che, sotto il profilo sperimentale, possono

risultare problematici. Gli edifici devono essere abbastanza complessi da

richiedere una rappresentazione non banale e, durante le sessioni sperimentali,

devono essere disabitati.

Ulteriori problemi emergono durante l'esperimento: i movimenti, le azioni ed i

comportamenti dei soggetti non possono essere registrati con precisione, e

possono venire raccolti solo rincorrendo i soggetti. La traduzione dei dati

raccolti in formato elettronico richiede infine un lavoro considerevole.

Gli ambienti di realtà virtuale possono costituire la soluzione di molti dei

problemi delineati. I ricercatori possono creare edifici su misura per

l'esperimento, arredandoli in maniera adeguata al disegno sperimentale. I

soggetti possono liberamente navigare, esplorare, cercare: il software

dell'ambiente virtuale può registrare movimenti ed azioni con la risoluzione

temporale e spaziale desiderata. E' infine possibile creare tipi di interazioni

che nella realtà non possono esistere.

Vi sono, naturalmente, alcuni problemi: l'interazione di un soggetto in un

ambiente virtuale è tuttora molto diversa dall'immersione in uno spazio reale:

nella realtà virtuale la percezione è più povera, il feedback è limitato e la

navigazione immersiva può causare malessere: lo sviluppo tecnologico sta

comunque migliorando la qualità ed il realismo dell'interazione immersiva,

rendendo la realtà virtuale uno strumento estremamente promettente.

Il software e gli applicativi dedicati alla realtà virtuale presenti sul

mercato, pur se estremamente potenti e sofisticati, non sono naturalmente stati

progettati per la creazione di settings sperimentali, e buona parte delle

funzioni e procedure specifiche necessarie alla realizzazione di un esperimento

di psicologia cognitiva dev'essere programmato ex novo.

La costruzione di un setting sperimentale può essere concettualmente divisa in

tre filoni principali: creare l'ambiente, gestire l'interazione del soggetto,

registrarne le azioni.

ROBOTICA

ROBOTICA

La robotica è una scienza che, studiando i comportamenti degli esseri

intelligenti, cerca di sviluppare delle metodologie che permettano ad una

macchina (), dotata di opportuni dispositivi atti a percepire l'ambiente

circostante ed interagire con esso quali e , di eseguire dei compiti specifici.

È una disciplina relativamente nuova, che affonda le sue radici nell'antico

desiderio dell' di costruire strumenti che possano liberarlo da compiti troppo

faticosi, noiosi o pericolosi. Anche se la robotica è una branca dell' in essa

confluiscono gli studi di molte discipline sia di natura umanistica come , , e

che scientifica quali , , , , e

La scienza robotica proprio in virtù della sua natura trova applicazioni in

molteplici contesti, questo ha fatto sì che nascessero varie sotto-discipline

fra le quali però raramente esiste una netta linea di demarcazione.

Robotica utilizzata sia per creare nuove forme di sia per imitare e riprodurre

le forme artistiche gia esistenti come i robot progettati per o per suonare uno

strumento musicale analizzando in uno .

Robot usati in campo medico

Automazione applicata all'ambiente domestico, tra gli sviluppi a breve termine

più interessanti ci sono le tecnologie di aiuto in casa ai portatori di mentali

o fisici.

· si occupa dello studio e della diffusione di piccoli robot a basso costo

utilizzati per scopi educativi o ludici

· ramo della robotica molto vasto comprende diversi tipi di robot; si va infatti

dai robot capaci di assitere il medico durante le operazioni chirugiche a quelli

che tramite tecnologie di permettono al medico di operare a distanza. Rientrano

nella categoria anche le sofisticate apparecchiature per analisi biologiche

utilizzate nei laboratori

· si occupa delle tecnologie utilizzate nei parchi tematici, nei musei o negli

effetti speciali cinematografici per intrattenere ed educare grandi quantità di

pubblico; un esempio di utilizzo sono gli spesso utilizzati per riprodurre le

fattezze di personaggi fantastici o di specie animali oggi come i dinosauri.

· metodologia che attraverso lo studio di tenta di realizzare robot sempre più

versatili in modo da rendere meno essenziale il supporto umano.

il campo industriale è sicuramente quello in cui i robot hanno trovato maggiore

diffusione il loro impiego nelle ha permesso alle aziende di abbattere

notevolmente i costi accelerando e migliorando la produzione. Fra i robot più

utilizzati dall'industria vi è il o costruito a imitazione del braccio umano ma

spesso dotato di più è una macchina molto versatile che si presta a svariate

mansioni tra cui verniciatura, saldatura o montaggio. Interessante notare come

questa tipologia di macchine sia spesso utilizzata per produrre altri robot

simili rendendo le speculazioni fatte dalla sulle un discorso molto più vicino

alla nostra quotidianità.

Anche se la fantascienza è ricca di riferimenti a robot utilizzati in ambito

militare nel pratico questi sono utilizzati più che altro con scopi di

ricognizione e vigilanza fra i quali troviamo ad esempio gli aerei privi di

equipaggio detti . Questo tipo di veicoli è sì controllato a distanza da

personale apposito ma in caso di emergenza può anche compiere diversi compiti in

totale autonomia permettendo la ricognizione di teatri di guerra pesantemente

difesi senza mettere a repentaglio vite umane. Altro esempio di robotica

militare sono i che sono in grado, grazie al numeroso set di strumenti di cui

sono muniti, di compiere analisi su un ordigno ed eventualmente neutralizzarlo a

distanza riducendo drasticamente i rischi per gli .

cerca di sviluppare tecnologie che rendano i robot sempre più capici di

interagire e comunicare con gli esseri umani in modo autonomo.

Anche se sviluppa tecnologie e metodiche destinate all'impiego di robot fuori

dall'atmosfera terrestre questo settore della robotica ha raggiunto dei

risultati utili anche in campi che esulano dalla ricerca spaziale. Esempi di

questi robot sono le sonde esplorative impiegate in diversi missioni sui pianeti

del sistema solare ma anche robot più tradizionali come il famoso braccio

manipolatore dello o quello di sembianze umane destinato alla che verrà

utilizzato in sostituzione degli austronauti nelle spedizioni spaziali.

Nel linguaggio comune, un robot è un'apparecchiatura artificiale che esegue

compiti su comando (o programma), sia in base ad una supervisione diretta

dell'uomo, sia autonomamente basandosi su linee guida generali, magari usando

processi di ; questi compiti tipicamente dovrebbero essere performati al fine di

sostituire o coadiuvare l'uomo, come ad es. nella fabbricazione, costruzione,

manipolazione di materiali pesanti e pericolosi, o in ambienti proibitivi o non

compatibili con la condizione umana o semplicemente per liberare l'uomo da

impegni.

Un robot così definito, dovrebbe essere dotato di connessioni guidate dalla tra

percezione e azione, e non dal controllo umano diretto. L'azione può prendere la

forma di motori elettro-magnetici, o , che muovono un arto, aprono e chiudono

una pinza, o fanno deambulare il robot. Il controllo passo-passo e la

retroazione sono forniti da un che viene eseguito da un esterno o interno al

robot, o da un . In base a questa definizione, il concetto di robot può

comprendere quasi tutti gli apparati automatizzati.

In alternativa, il termine robot viene usato per indicare un essere artificiale,

un o , che replichi e somigli ad un animale (reale o immaginario) o ad un uomo.

Il termine ha finito per essere applicato a molte macchine che sostituiscono

direttamente un umano o un animale, nel lavoro o nel gioco. In questo modo, un

robot può essere visto come un tentativo di . L' è forse ciò che ci rende così

riluttanti a riferirci a una moderna e complessa lavatrice, come a un robot.

Comunque, nella comprensione moderna, il termine implica un grado di autonomia

che escluderebbe molte macchine automatiche dal venire chiamate robot. Si tratta

di una ricerca per robot sempre più autonomi, il che è il maggiore obbiettivo

della ricerca robotica e il motivo che guida gran parte del lavoro sull'..

Origine del termine robot

Il termine robot deriva dal termine robota, che significa "lavoro pesante" o

"lavoro forzato". L'introduzione di questo termine si deve allo scrittore ceco ,

il quale usò per la prima volta il termine nel nel suo dramma teatrale . In

realtà non fu il vero inventore della parola, la quale infatti gli venne

suggerita dal fratello , scrittore e pittore cubista, il quale aveva già

affrontato il tema in un suo racconto del , ("L'ubriacone"), nel quale però

aveva usato il termine automat, "". La diffusione del romanzo di , molto

popolare sin dalla sua uscita, servì a dare fama al termine Robot.

Anche se i robot di Čapek erano uomini artificiali , la parola robot viene quasi

sempre usata per indicare un uomo meccanico. Il termine (dal greco anèr, andròs,

"uomo", e che quindi può essere tradotto "a forma d'uomo") può essere usato in

entrambi i casi, mentre un ("organismo cibernetico" o "uomo ") indica una

creatura che combina parti organiche e meccaniche.

Il termine "robotica" venne usato per la prima volta (su carta stampata) nel

racconto di intitolato Circolo vizioso (Runaround, ), presente nella sua famosa

raccolta . In esso, egli citava le tre regole della robotica, che in seguito

divennero le (poi accresciute a quattro con l'introduzione della Legge Zero). È

probabile che in un prossimo futuro queste leggi entreranno effettivamente a

fare parte del set di istruzioni dei robot complessi

Il primo progetto documentato di un robot umanoide venne fatto da attorno al .

Degli appunti di Da Vinci, riscoperti negli , contengono disegni dettagliati per

un cavaliere meccanico, che era apparentemente in grado di alzarsi in piedi,

agitare le braccia e muovere testa e mascella. Il progetto era probabilmente

basato sulle sue ricerche anatomiche registrate nell . Non si sa se tentò o meno

di costruire il robot (vedi: ).

Il primo robot funzionante conosciuto venne creato nel da , che fabbricò un

androide che suonava il , così come un'anatra meccanica che, secondo le

testimonianze, mangiava e defecava. Nel racconto breve di E.T.A. Hoffmann L'uomo

di sabbia () compariva una donna meccanica a forma di bambola, nel racconto ()

indicò l'invenzione dei robot (da lui chiamati 'omuncoli', 'uomini di seconda

mano' o 'esseri ausiliari') come l'invenzione più notevole della storia

dell'umanità, e in Steam Man of the Prairies () Edward S. Ellis espresse l'affascinazione

americana per l'industrializzazione. Giunse un'ondata di storie su automi

umanoidi, che culminò nell' Uomo elettrico di , nel .

Una volta che la tecnologia avanzò al punto che la gente intravedeva delle

creature meccaniche come qualcosa più che dei giocattoli, la risposta letteraria

al concetto di robot rifletté le paure che gli esseri umani avrebbero potuto

essere rimpiazzati dalle loro stesse creazioni. (), che viene spesso definito il

primo romanzo di fantascienza, è divenuto un sinonimo di questa tematica. Quando

il dramma di Čapek, R.U.R., introdusse il concetto di una catena di montaggio

operata da robot che costruivano altri robot, il tema prese delle sfumature

politiche e filosofiche, ulteriormente disseminate da film classici come (), il

popolare (), () e () .

Nella introduzione al suo romanzo , Asimov ha detto di avere fatto in tale serie

"Il primo uso della parola robotica nella storia del mondo, per quanto ne so."

ANDROIDE

L'androide è un essere artificiale, un , con sembianze umane (il termine deriva

dal greco anèr, andròs, "uomo", e quindi può essere tradotto "a forma d'uomo")

presente soprattutto nell'immaginario . In taluni casi l'androide può risultare

indistinguibile dall'. Differisce dal , il quale è costituito da parti

biologiche oltre che artificiali.

Il corrispettivo femminile del termine androide è l'assai poco frequente .

Presente soprattutto nell'immaginario , il termine cyborg o organismo bionico

indica un essere di forma costituito da un insieme di organi artificiali e

organi . Nasce dalla contrazione dell'inglese cybernetic organism, .

Il confine tra essere umano e cyborg è sempre più sfumato, basti pensare ai

progressi delle tecnologie applicate alle e agli organi artificiali: una persona

dotata di un potrebbe infatti già corrispondere alla definizione di cyborg.

A seconda della loro origine, è tuttavia possibile distinguere i cyborg in due

categorie:

1. Esseri umani potenziati. Può trattarsi di un essere umano che ha subito

consistenti modificazioni ed innesti. Esempio: il protagonista del film è un

poliziotto che, ucciso in servizio, viene fatto resuscitare in forma di cyborg.

2. , cioè robot umanoidi, provvisti di apporti biologici, spesso allo scopo di

aumentare la loro somiglianza con l'essere umano. È il caso del cyborg assassino

protagonista del film () e dei due seguiti.

la tendenza naturale degli esseri umani è quella di ricostruirsi attraverso la

tecnologia allo scopo di distinguersi dalle altre forme biologiche del pianeta:

un progetto che parte dalle prime forme di manipolazione del e continua oggi con

l'utilizzo di protesi tecnologiche e lo sviluppo dell'. Il desiderio di

migliorare ciò che ha determinato la natura, sarebbe alle origini stesse della

cultura umana.

Letteratura

La fusione tra uomo e macchina, cantata dai poeti e artisti del già prima

dell'invenzione della , è un'ossessione condivisa particolarmente dagli

scrittori del filone fantascientifico , nato nei primi : i personaggi dei

romanzi di , ad esempio, sono spesso dotati di innesti artificiali che ne

potenziano la forza ed altre capacità. L'icona in questo caso è Molly, la

guardia del corpo dotata di riflessi potenziati e fibre muscolari artificiali,

che si è fatta togliere gli occhi per sostituirli con delle inquietanti lenti a

specchio saldate alle orbite oculari.

TELEROBOTICA

TELEROBOTICA PER

INTERVENTI CHIRURGICI

Le ricerche svolte riguardano realizzazione di un sistema per il telecontrollo

di un robot composto da:

- stazione di controllo dove il teleoperatore pilota gli spostamenti del robot

remoto tramite un mouse disponendo di tre telecamere che inquadrano la scena.

- stazione operativa composta da un elaboratore di controllo della comunicazione

e da un robot.

Le ricerche sono state svolte utilizzando:

- stazione di telecontrollo

- personal computer WIN SERVER 2005 compatibile

-r basato su microprocessore PC INTE PENTIUM 9.7Ghb-Video3D

- Windows VISTA/UNIX

- robot MICROSOFT 7575

- linguaggio XML/Unix LINUX

Il sistema e' stato utilizzato durante il congresso Roma Chirurgia '05

telecontrollando il robot posto in una sala chirurgica del Policlinico Umberto I

di Roma da Milano via sat,inoltre tale siatema è stato usato durante un'intertento

delicatissimo nel 2006 in collegamento via sat Clinica Gemelli di Roma e

Universital Ospital NYC,con risultati sbalorditivi mai visti prima ,l'intervento

riuscito brillantemente è stato solo l'inizio di una lunga e innovativa svolta

in questo millenio,altri interventi chirurgici di spicco si sono verificati

tutti con le stesse metodiche e con risultati ottimi.